Paper Reading: Embodied AI 9

从一些 Embodied AI 相关工作中扫过。

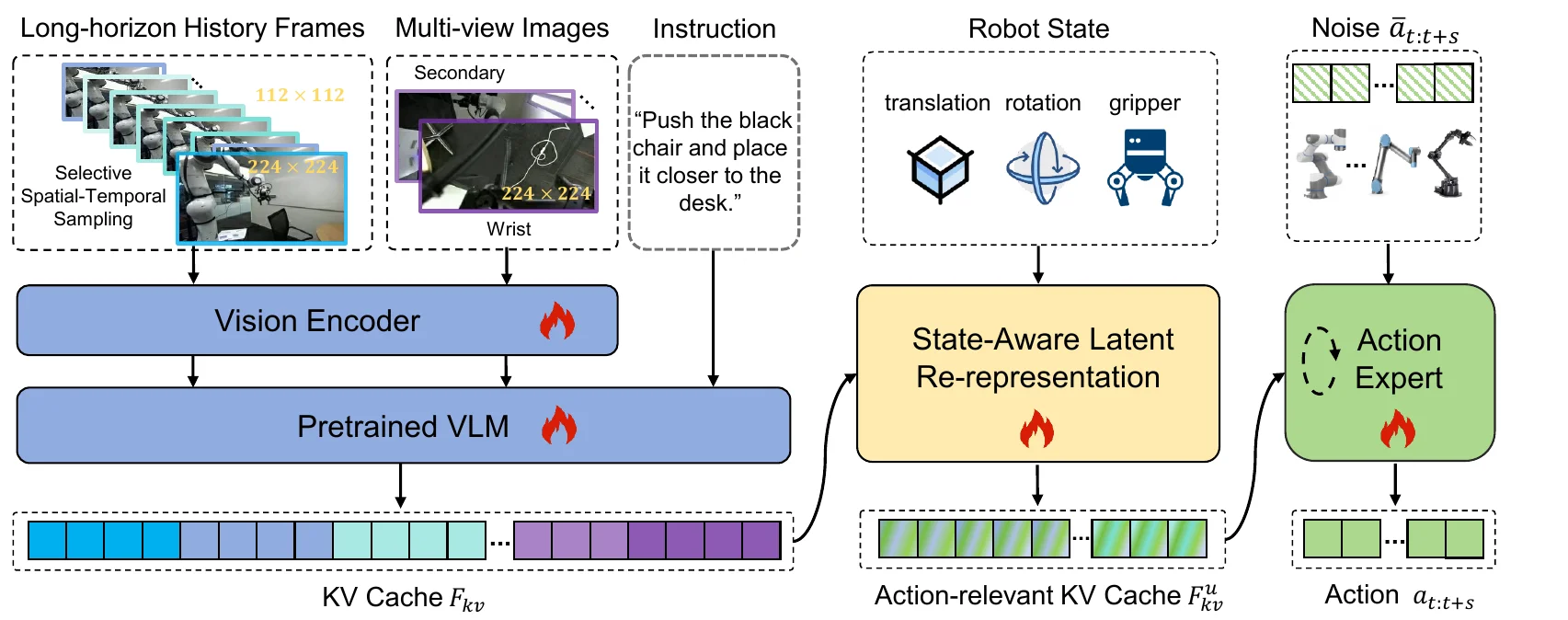

LoLA#

本文针对长时域机器人任务提出 LoLA 框架,通过状态感知的潜在重表示模块将视觉-语言嵌入映射到机器人运动空间。该方法整合历史多视角观测与机器人状态信息,实现时序推理和连贯动作生成。在 SIMPLER、LIBERO 仿真基准和 Franka、双臂 Aloha 真实机器人上的实验证明,该方法在长时域操作任务中显著优于现有方法。

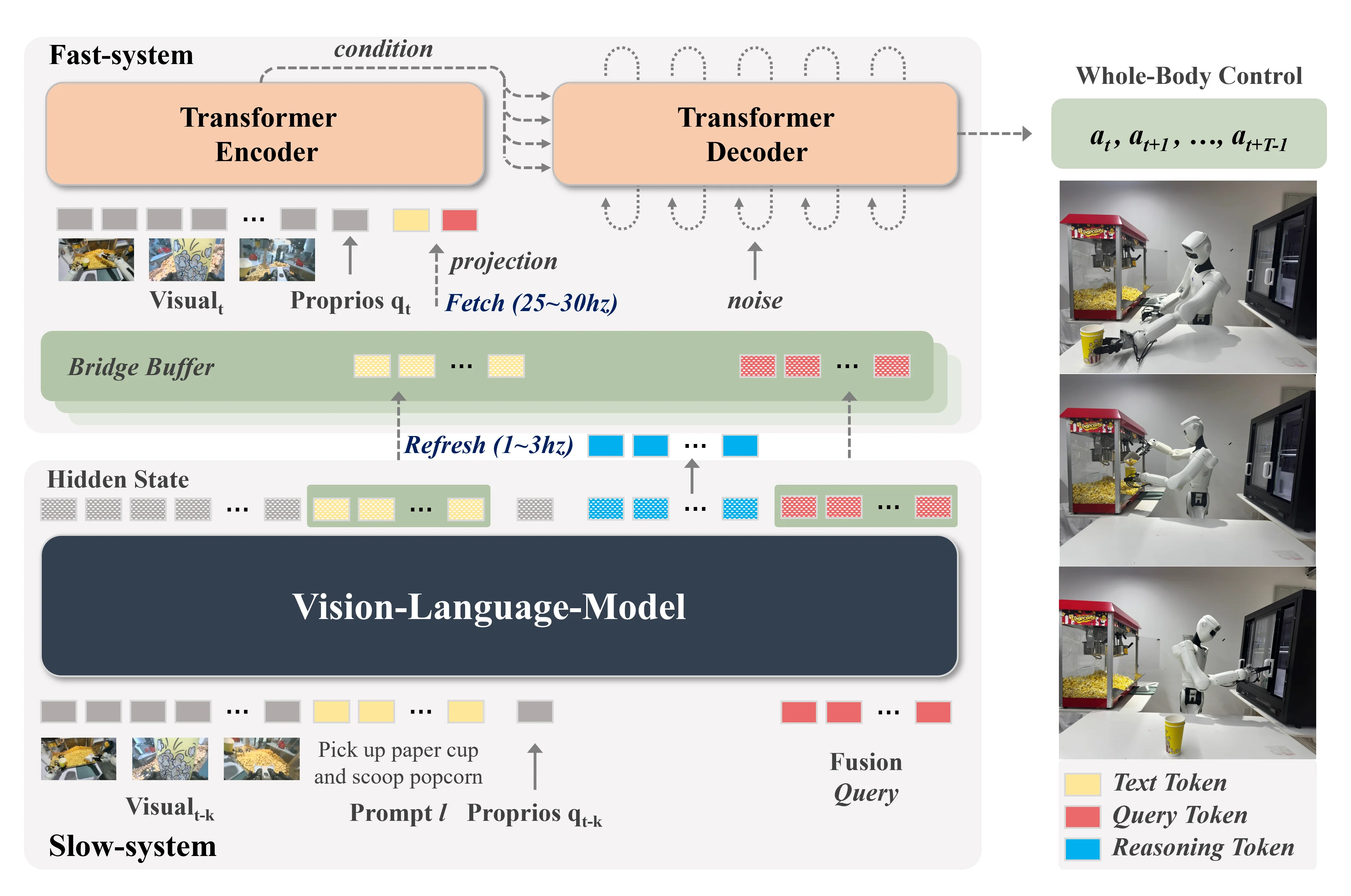

DuoCore-FS#

本文提出 DuoCore-FS 框架,通过异步快-慢双通路架构解决视觉-语言模型推理速度慢的瓶颈问题。该方法设计快速通路用于高频动作生成,慢速通路用于视觉-语言推理,通过潜在表示缓冲区存储指令语义和动作推理表示。系统实现了端到端联合训练,达到 30 Hz 全身动作生成速度,比同类模型快约 3 倍,真实实验验证了其任务成功率和响应速度的提升。

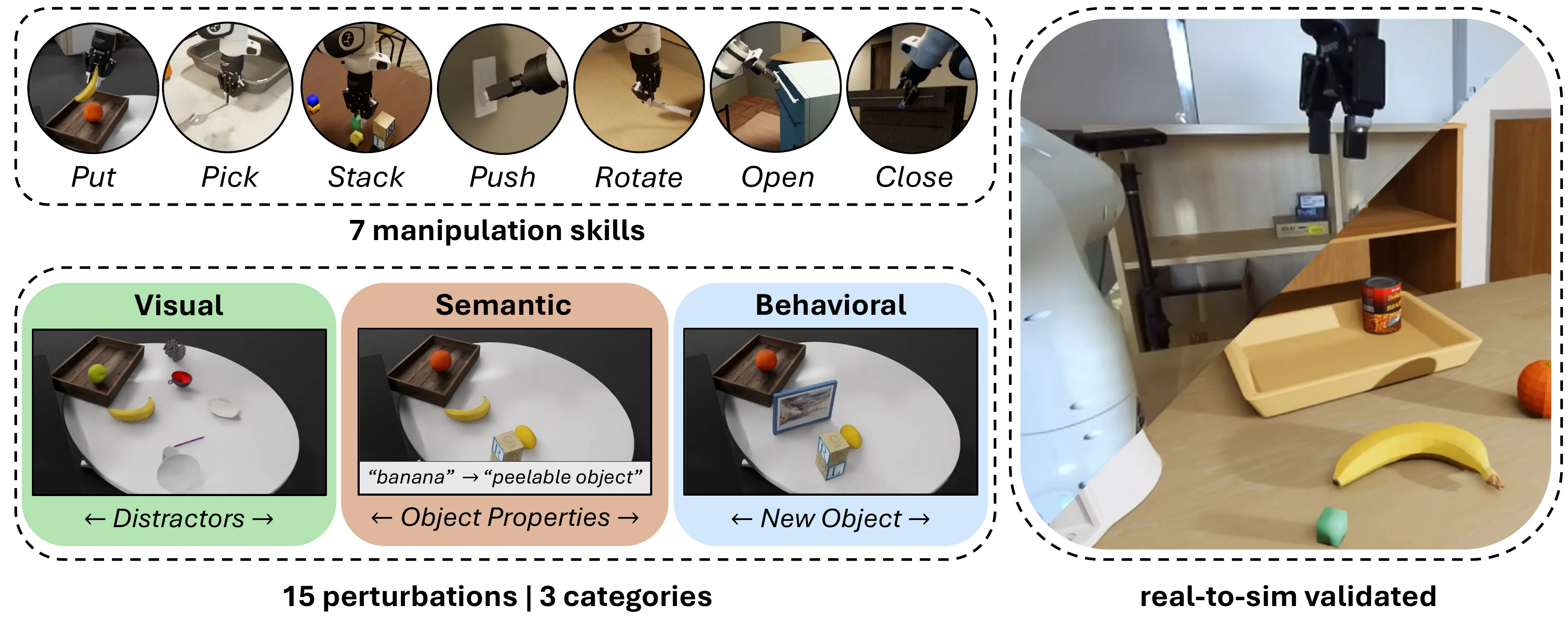

REALM#

本文提出 REALM 仿真基准平台,用于系统评估视觉-语言-动作模型在机器人操作任务中的泛化能力。该基准包含 15 种扰动因素、7 种操作技能和超过 3500 个物体,建立了仿真与真实世界结果的对齐验证。通过对 π₀、π₀-FAST、GR00T N1.5 等模型的评估,研究揭示了当前 VLA 系统在泛化和鲁棒性方面仍面临挑战,证明仿真可作为识别模型弱点的有效工具。

UniPred#

本文提出 UniPred 框架,通过符号世界模型与神经学习的结合解决长时域机器人任务。该方法利用大语言模型提出谓词效应分布来指导从演示中学习神经谓词,并通过学习反馈迭代优化 LLM 假设,同时使用视觉基础模型特征实现复杂场景中的鲁棒谓词分类。实验表明,UniPred 的成功率比自顶向下方法高 2-4 倍,学习速度比自底向上方法快 3-4 倍。

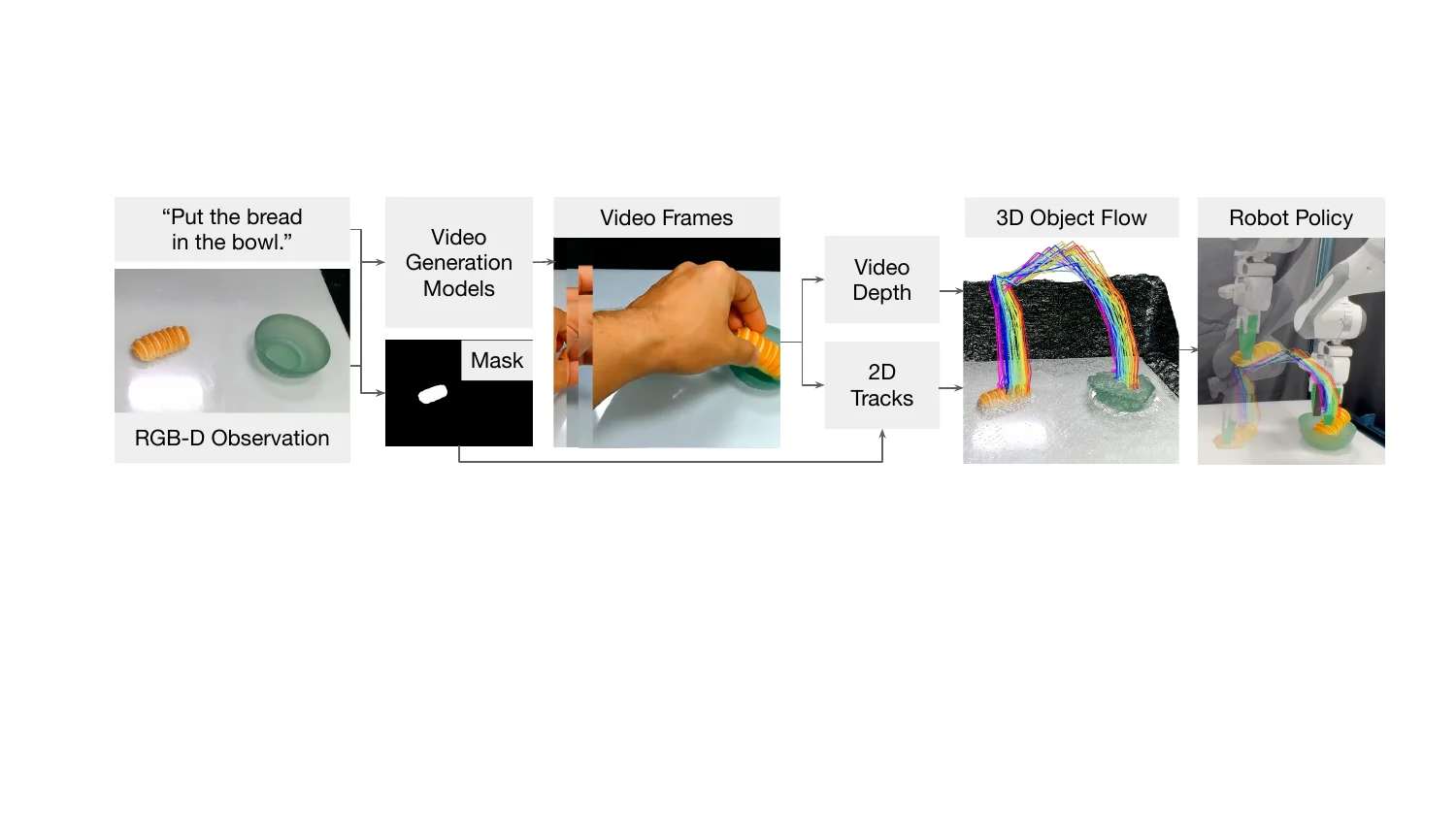

Dream2Flow#

本文提出 Dream2Flow 框架,通过 3D 物体流作为中间表示,将生成式视频模型与机器人操作连接起来。该方法从 AI 生成的视频中重建三维物体运动,将操作任务重构为轨迹跟踪问题,实现跨刚性、铰接、可变形和颗粒材料的零样本适配。通过轨迹优化或强化学习将流模式转换为可执行的机器人命令,无需任务特定训练数据,仿真和真实实验验证了该方法在开放世界场景中的有效性。

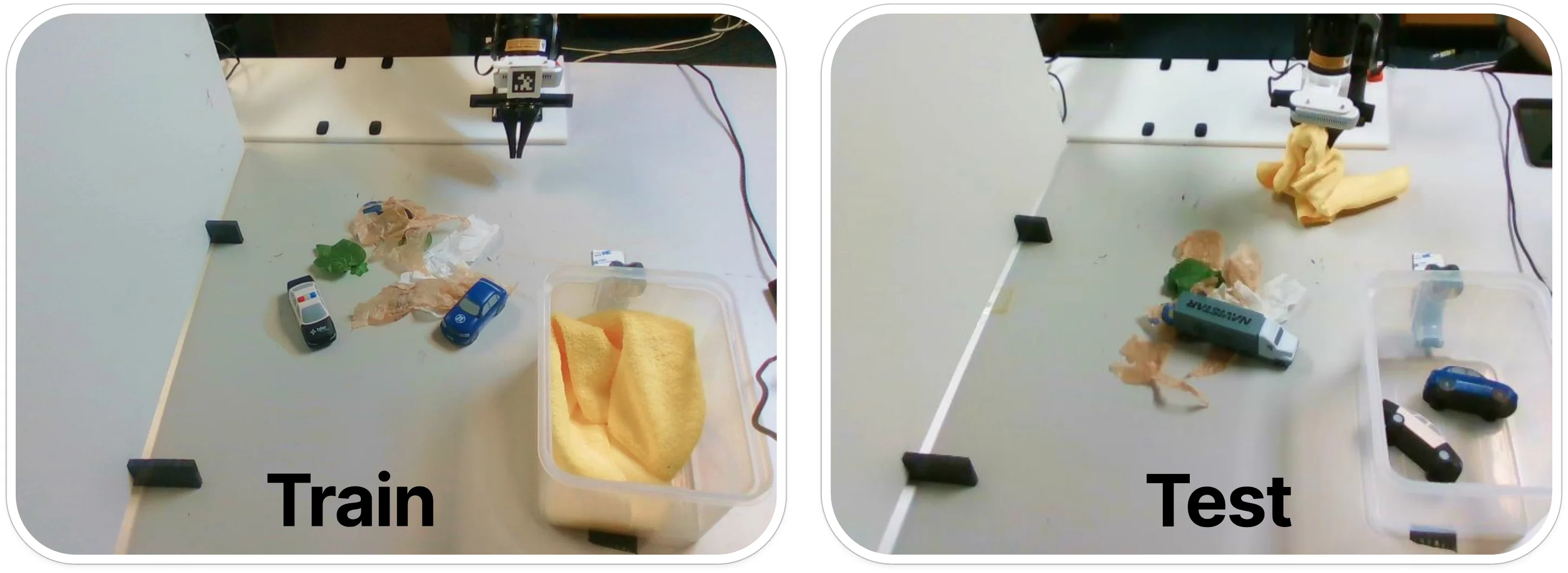

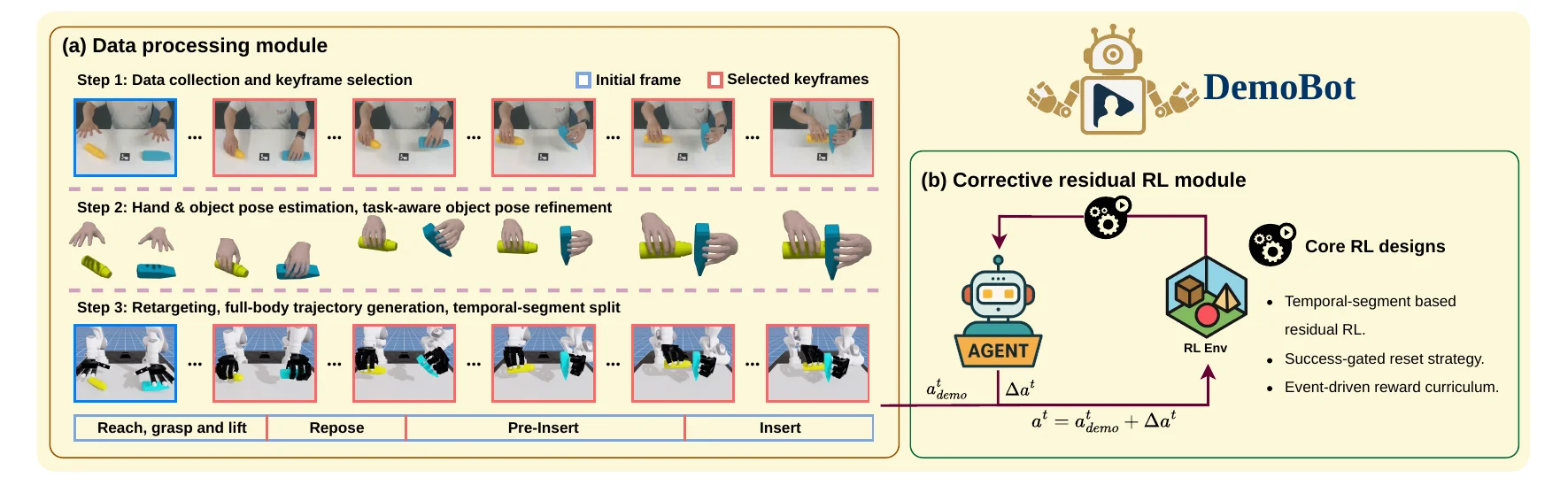

DemoBot#

DemoBot 提出了一个框架,使双臂机器人能够从单个 RGB-D 视频演示中学习复杂的双手操作任务。该方法从视频中提取运动轨迹作为运动先验,并通过新颖的强化学习管道来优化这些轨迹,结合了基于时序段的状态对齐、成功门控重置策略和事件驱动奖励课程。系统成功实现了长时域的双臂装配任务,为从人类视频演示中获取机器人技能提供了可扩展的方法。

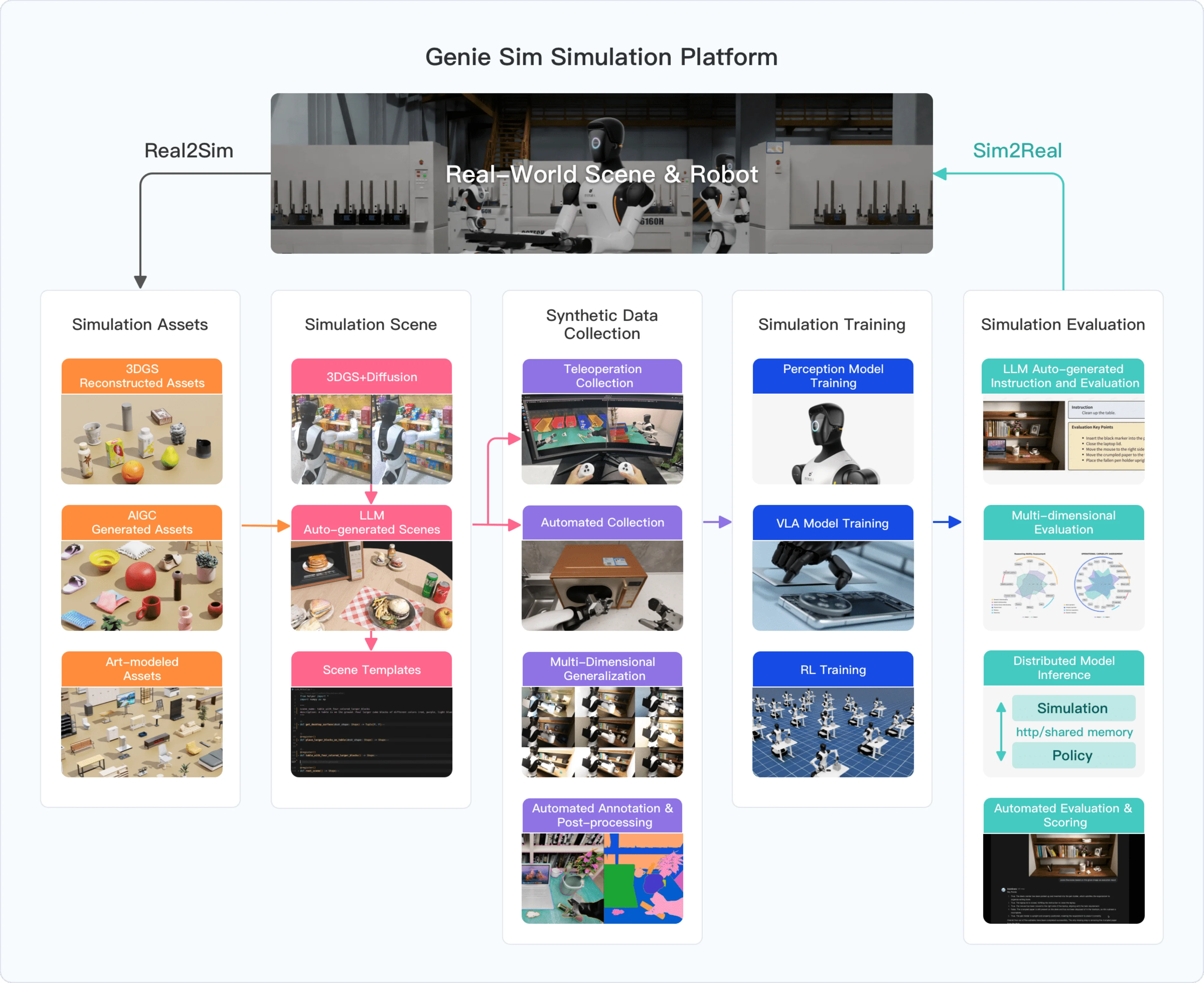

Genie Sim 3.0#

Genie Sim 3.0 是一个统一的高保真仿真平台,专为人形机器人操作任务设计。该平台采用大语言模型驱动的工具,可从自然语言指令生成高保真场景,并首创了利用 LLM 进行自动化评估的基准测试。研究团队发布了包含超过 10,000 小时合成训练数据的开源数据集(覆盖 200+ 任务),实验验证表明在该合成数据上训练的策略可以有效迁移到物理机器人,无需额外的真实世界适应。

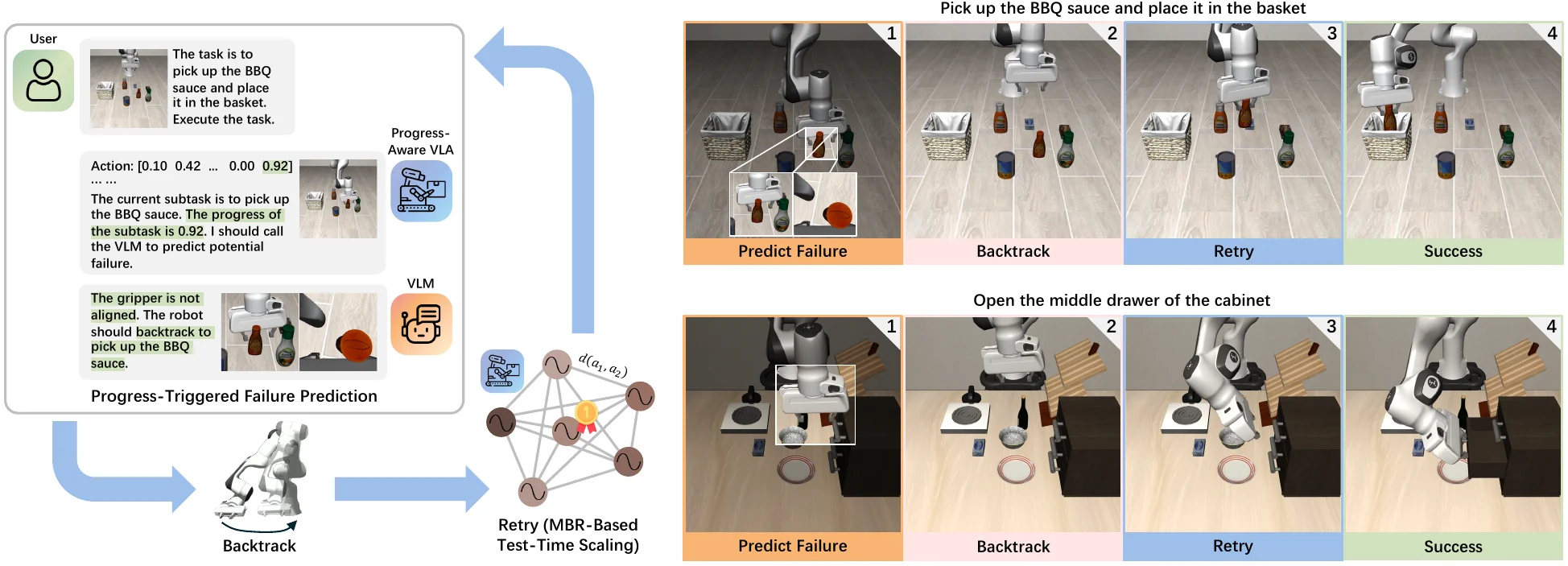

CycleVLA#

CycleVLA 提出了一个主动自我纠错的视觉-语言-动作模型,能够在机器人任务执行前预见并防止失败。该系统包含三个关键组件:能识别关键失败点的进度感知 VLA、预测失败并触发回溯的视觉-语言模型,以及使用最小贝叶斯风险解码的测试时扩展方法。实验表明该方法在不同 VLA 训练水平上都能提升性能,MBR 解码作为零样本扩展方法表现有效。

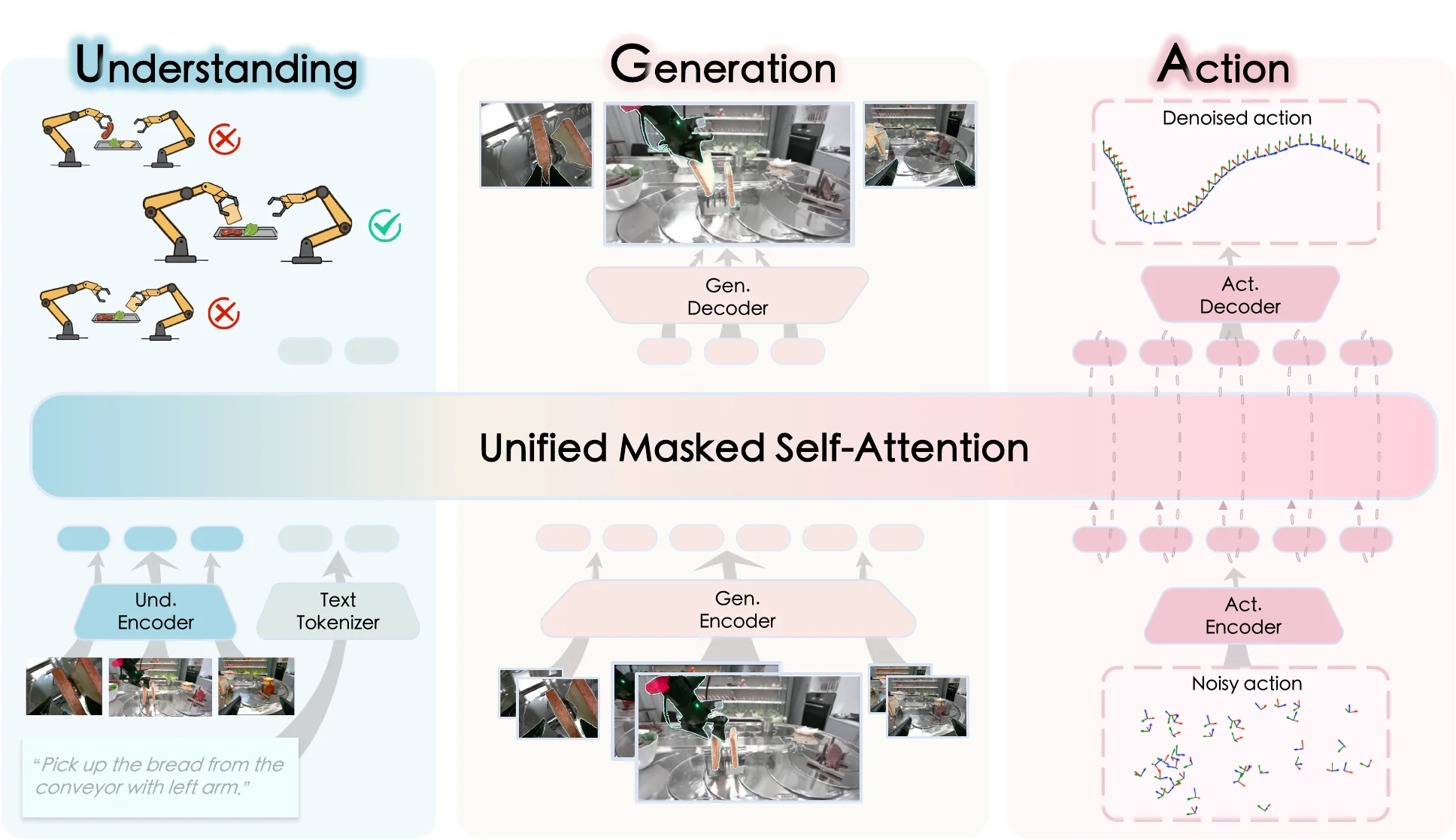

InternVLA-A1#

InternVLA-A1 统一了场景理解、视觉生成和动作执行能力,采用混合 Transformer 架构协调三个专家模块来实现语义理解与动态预测。模型分别实例化为 2B 和 3B 参数规模,在超过 5.33 亿帧的混合合成-真实数据集上训练。在 12 个真实机器人任务上的测试显示,相比 pi0 和 GR00T N1.5 等竞争系统,该系统在日常任务中实现了 14.5% 的性能提升,在传送带分拣等动态场景中提升了 40%-73.3%。

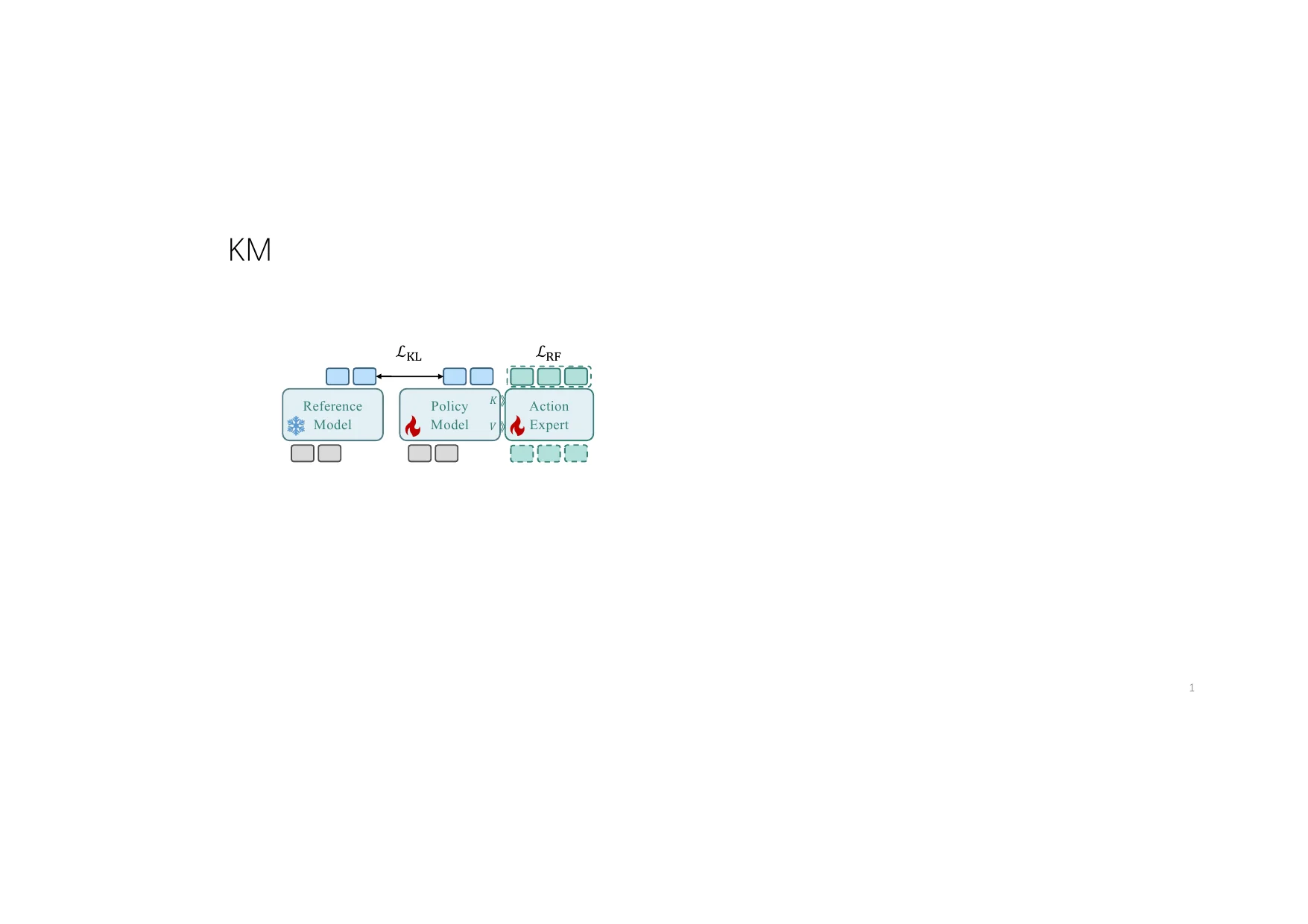

CLAP#

CLAP 通过对比学习将人类视频的视觉潜在空间与机器人轨迹的本体感知潜在空间对齐,解决了机器人训练数据不足的问题。该框架提供两种互补的策略:用于指令跟随任务的 CLAP-NTP 和用于精确操作的 CLAP-RF,并引入知识匹配正则化技术防止微调过程中的技能退化。实验表明 CLAP 显著优于强基线方法,有效实现了从人类视频到机器人执行的技能迁移。

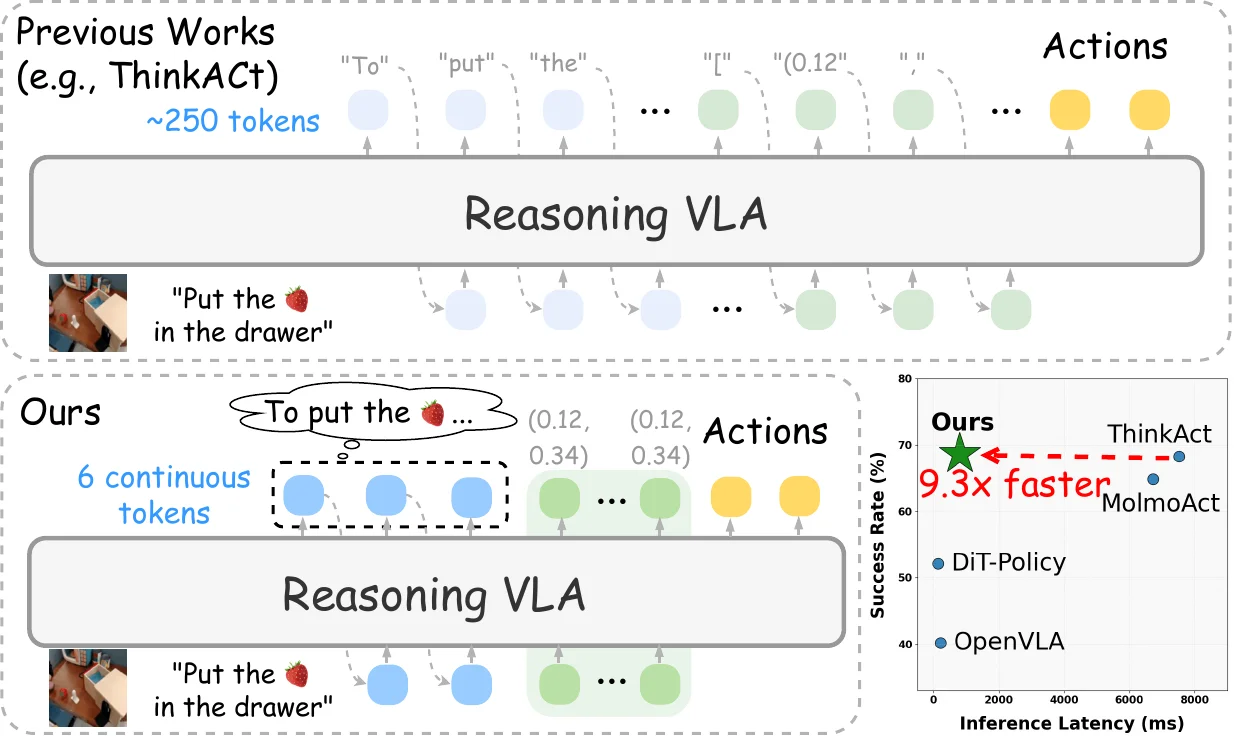

Fast-ThinkAct#

Fast-ThinkAct 通过”可言语化的潜在推理”实现高效的视觉-语言-动作推理,解决了 VLA 任务中的效率挑战。该方法通过教师蒸馏和偏好引导目标学习高效推理,将操作轨迹与视觉和语言规划对齐。相比最先进的推理 VLA 模型,该方法推理延迟降低高达 89.3%,同时保持了长时域规划、快速任务适应和错误恢复能力。

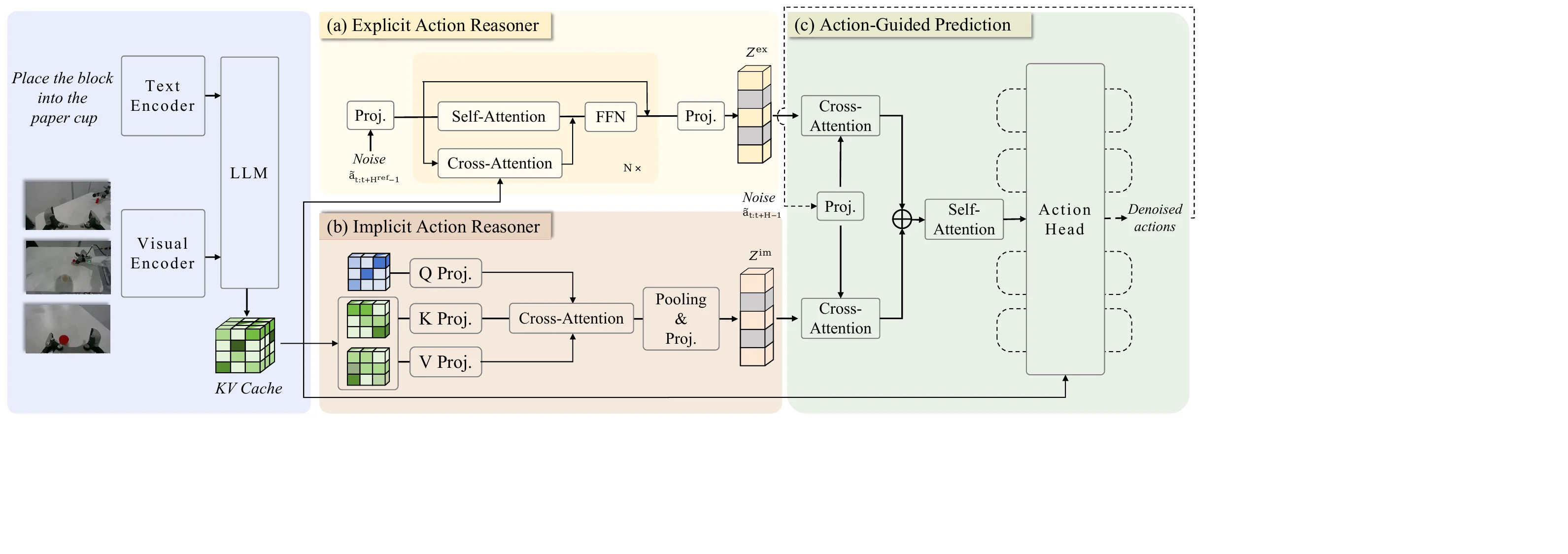

ACoT-VLA#

ACoT-VLA 提出了动作思维链方法,主张推理应直接在动作空间中进行,而非依赖间接推理方法。该架构结合了显式动作推理器(生成粗粒度参考轨迹)和隐式动作推理器(从多模态输入提取潜在动作先验),两者共同为下游动作头提供条件以改进策略学习。该方法在多个基准测试中表现优异,在 LIBERO 上达到 98.5%、LIBERO-Plus 上达到 84.1%、VLABench 上达到 47.4% 的成功率。

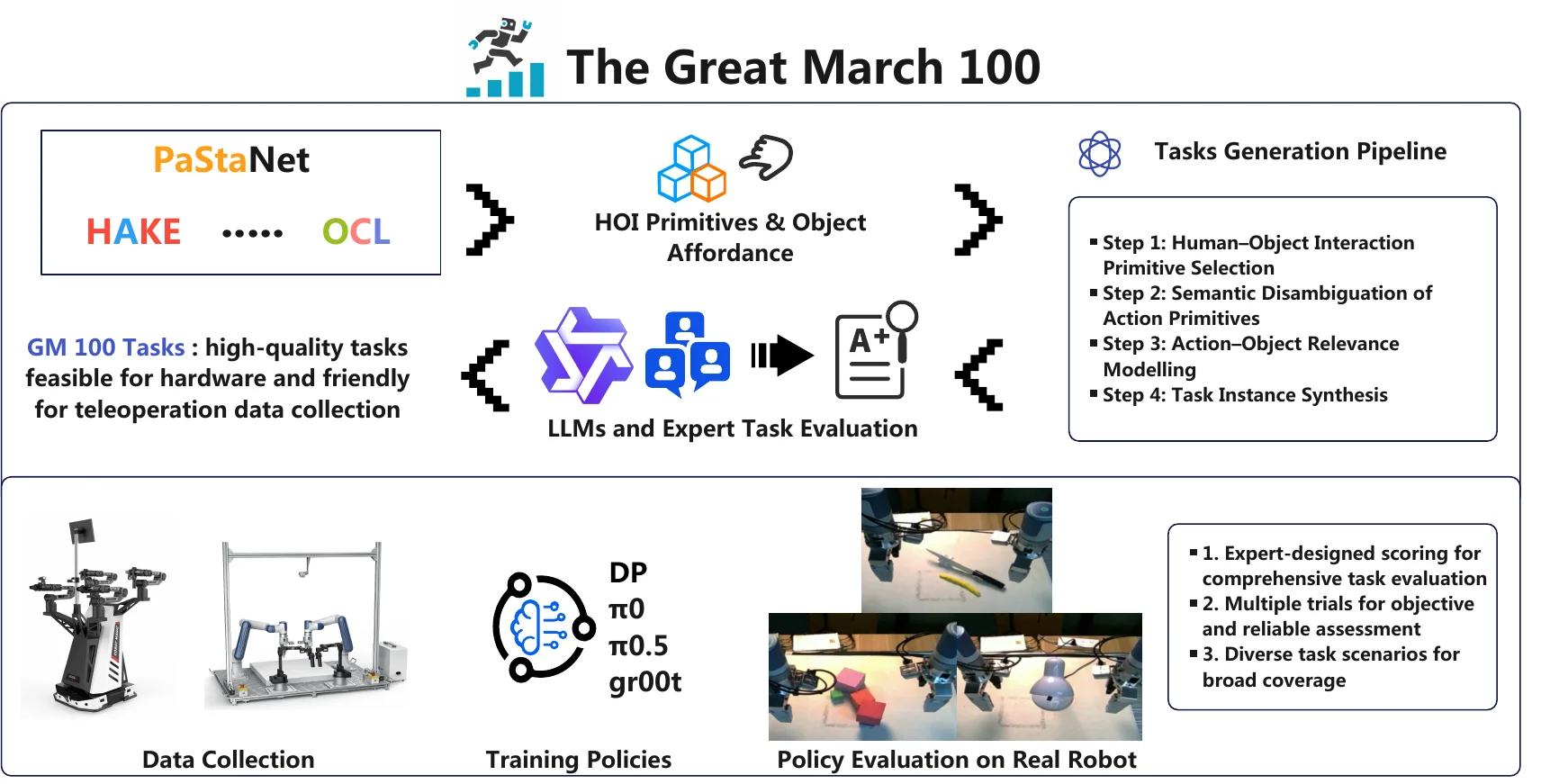

The Great March 100#

本研究针对现有机器人学习数据集任务设计缺乏系统性的问题,提出了包含100项详细任务的GM-100基准数据集。这些任务涵盖广泛的人-物互动行为,旨在全面评估具身AI智能体的性能,并有效区分不同方法的表现差异。

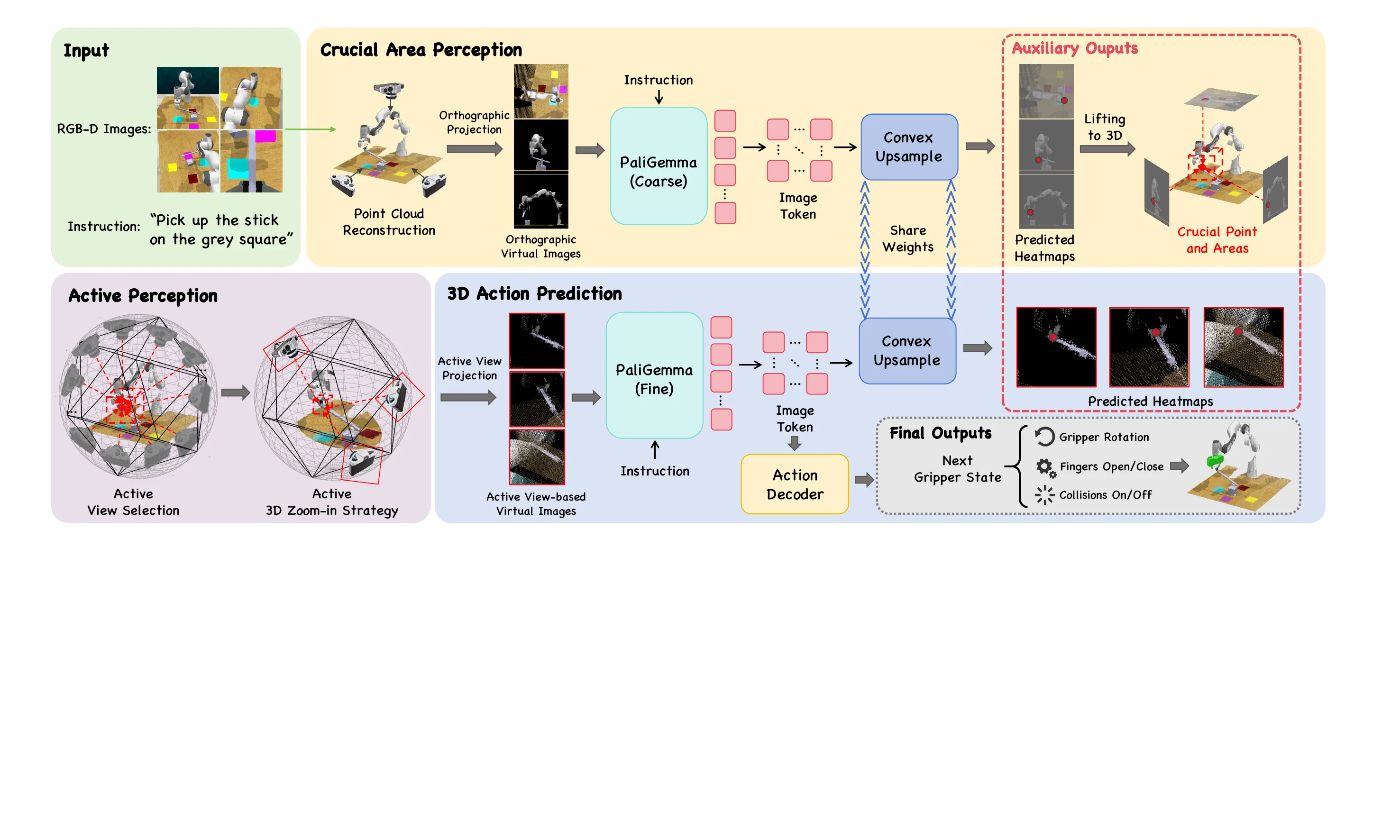

ActiveVLA#

本工作针对传统VLA模型依赖静态摄像头导致感知能力受限的问题,提出了一个具有主动感知能力的机器人操纵框架。该框架通过”关键区域定位”和”视角优化”两个环节,使机器人能够自适应地选择最优观察角度和分辨率,从而在模拟和真实场景中实现高精度的细粒度操纵任务。

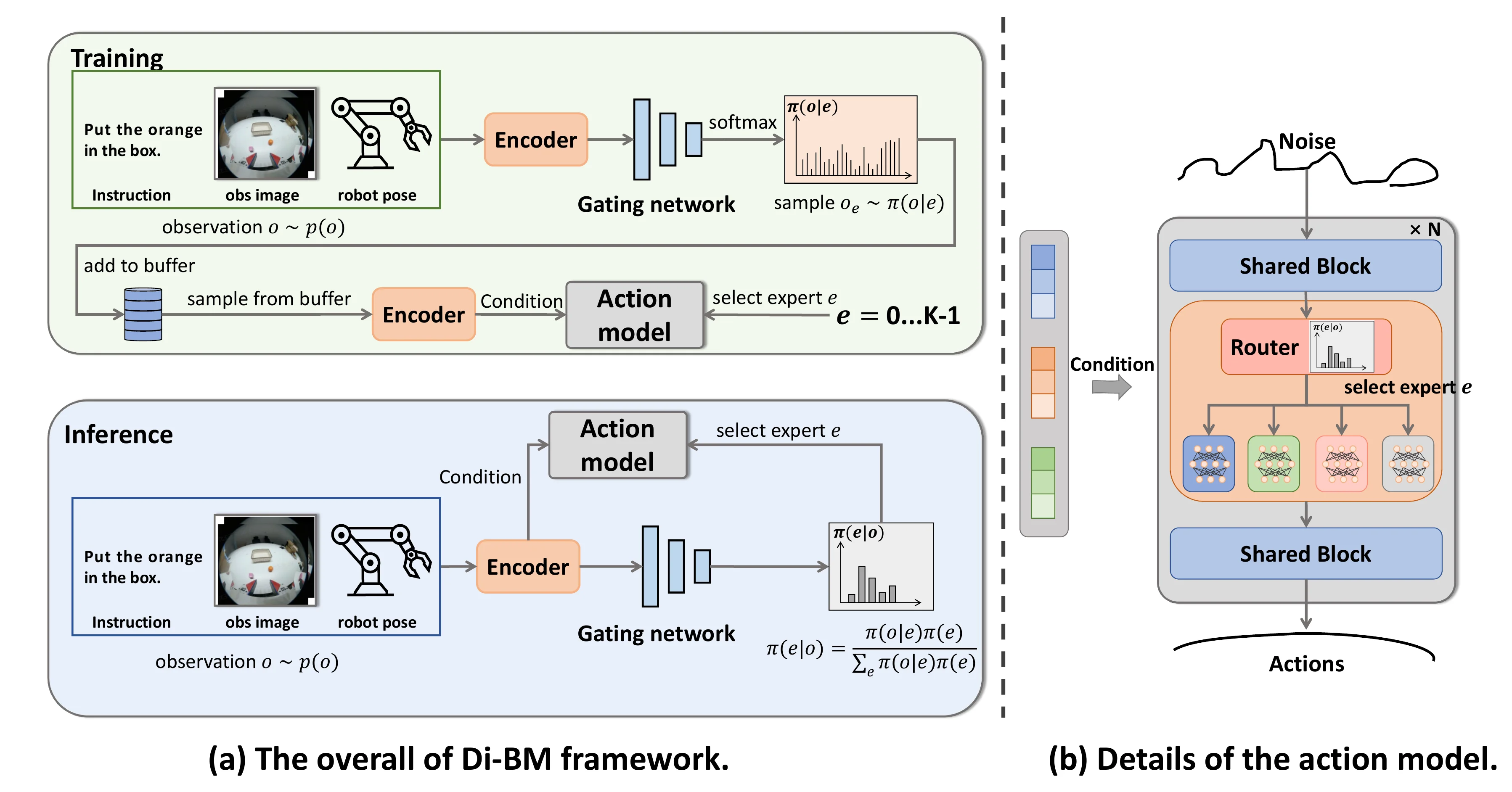

Di-BM#

该论文提出了Di-BM方法,通过混合专家模型为机器人行为学习引入多样化技能。针对多任务场景中任务干扰导致性能下降的问题,该方法让每个专家专注于观察空间的特定子区域,使用基于能量的模型来表示专家特定的观察分布。实验验证了该方法在多任务机器人操纵任务中的优越性,并展现了预训练模型的迁移学习效率。

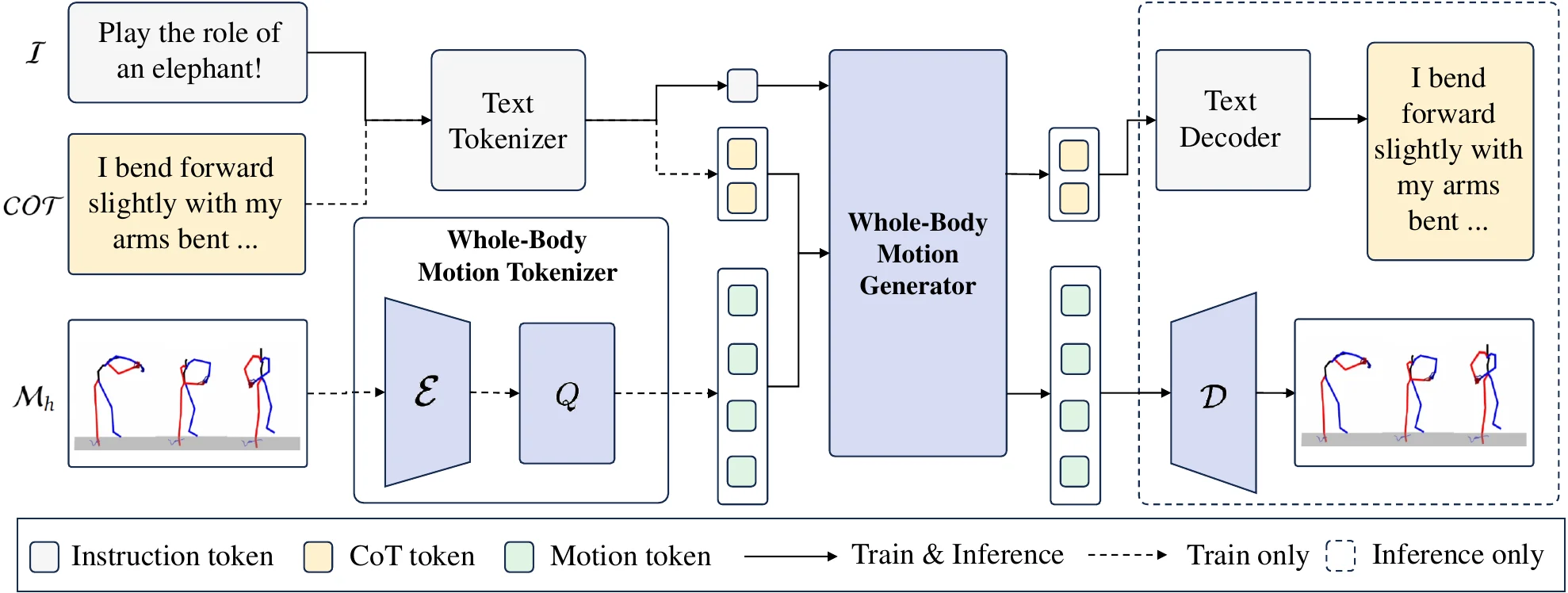

FRoM-W1#

本论文提出了一个开源框架,通过”将人类运动数据与大语言模型结合,再经由强化学习微调”的方式,使人形机器人能够理解和执行复杂的自然语言指令。该框架包含H-GPT(利用人类运动数据训练的语言驱动全身动作生成模型)和H-ACT(将生成的动作转换为机器人特定指令的强化学习模块),在Unitree H1和G1机器人上实现了从模拟到真实环境的成功迁移,显著提升了动作追踪精度和任务成功率。

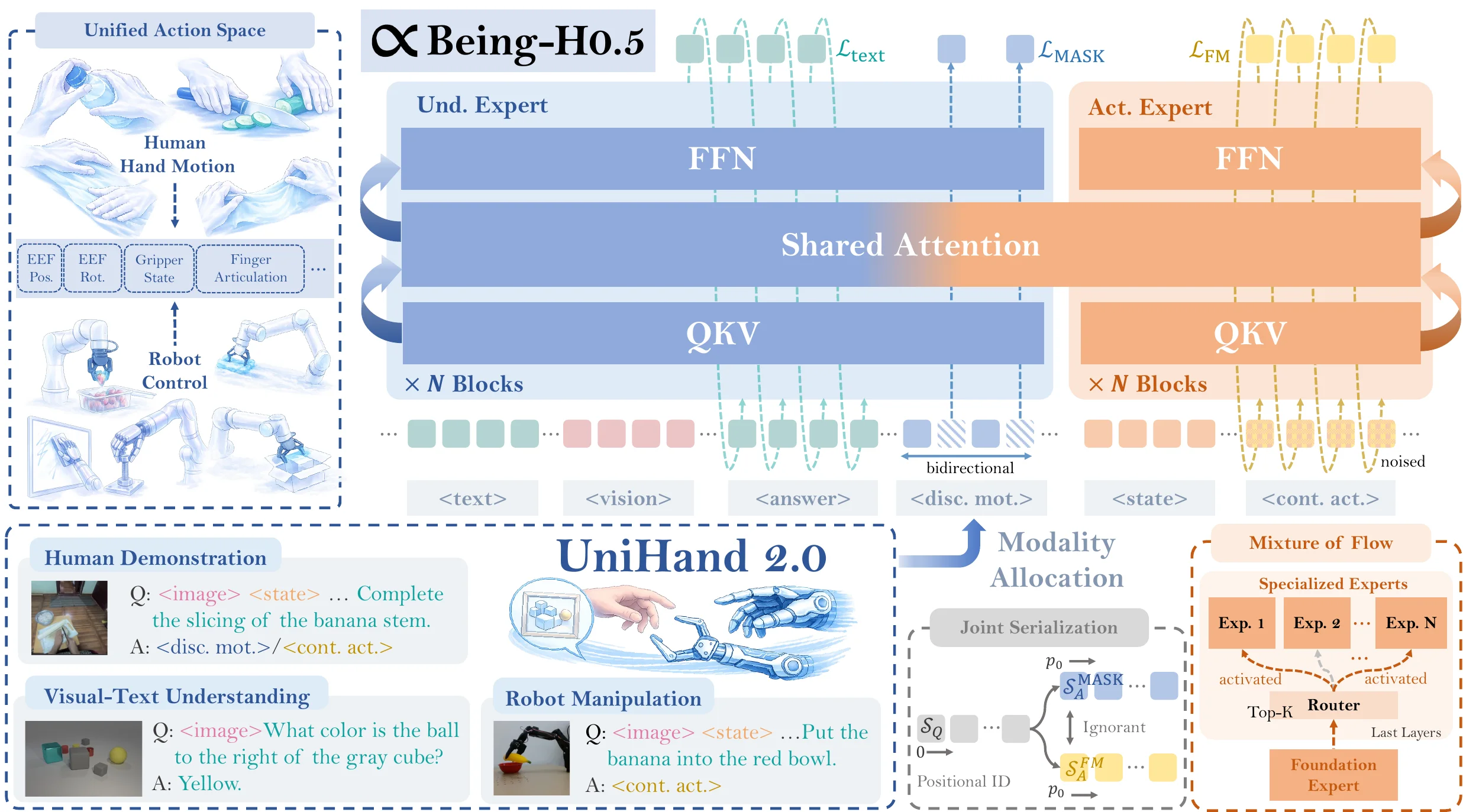

Being-H0.5#

本研究提出一个跨具身机器人通用学习框架,通过人类演示数据作为基础训练资源,设计了统一动作空间和混合流专家架构,使不同形态的机器人能够相互迁移学习技能。该方法建立在超过35,000小时的多模态数据集UniHand 2.0之上,采用人类中心学习范式将人类交互轨迹作为物理交互的通用参考。实验在模拟环境中达到先进水平(LIBERO 98.9%),并在五个真实机器人平台展现强大的跨具身泛化能力。

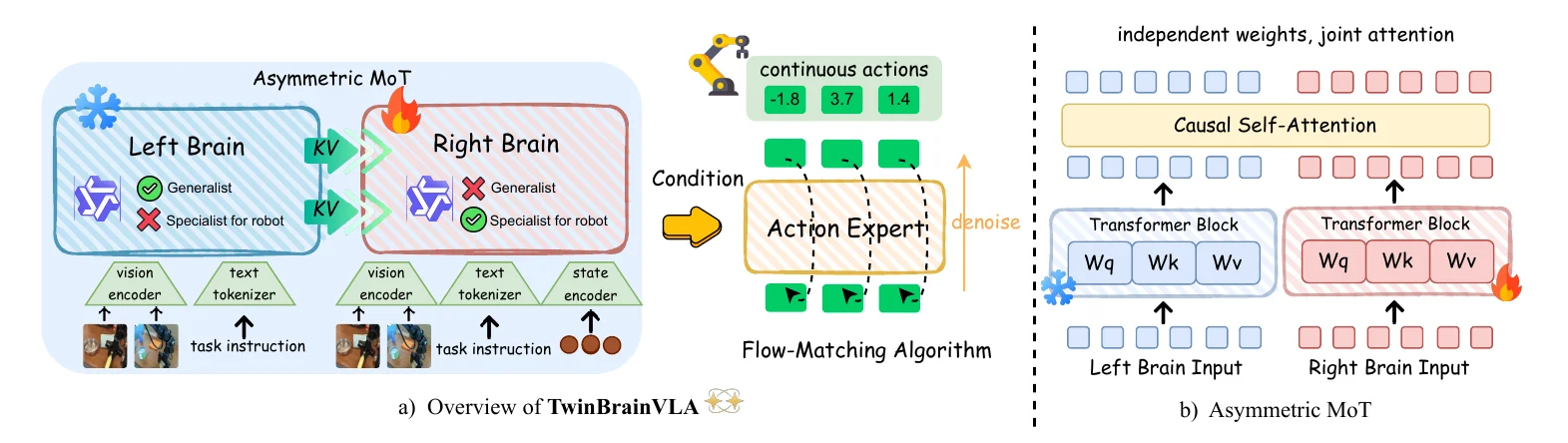

TwinBrainVLA#

该研究针对标准VLA模型微调时的”灾难性遗忘”问题,提出了TwinBrainVLA双脑架构。该架构通过”冻结的左脑”保留视觉推理能力,“可训练的右脑”学习机器人控制技能,两者通过非对称混合转换器机制协同工作。这种设计在SimplerEnv和RoboCasa基准上达到最先进性能,同时保留预训练VLM的视觉理解能力,为开发具有高级语义理解和低级物理灵巧性的通用机器人提供新方向。

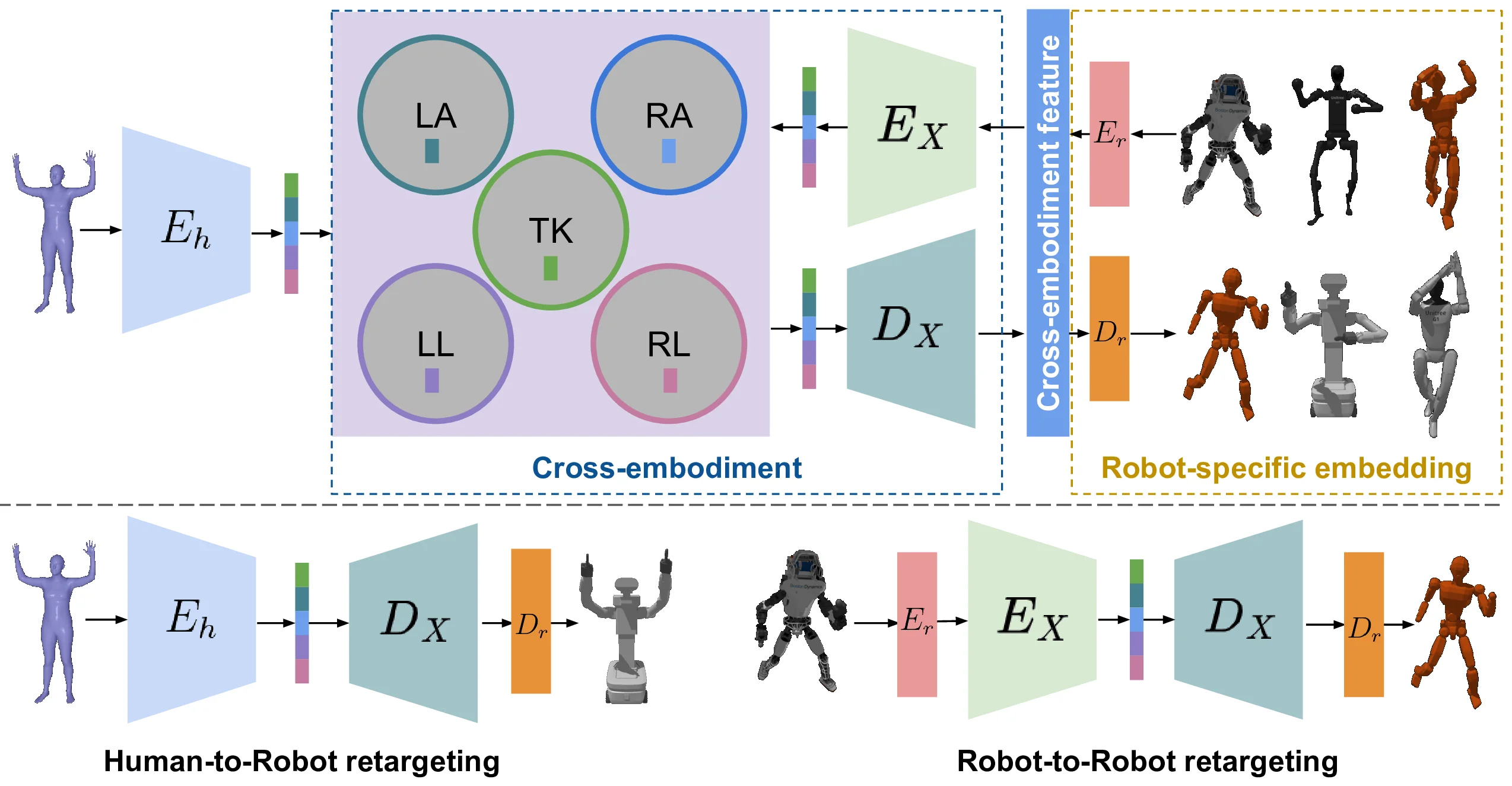

Cross-Embodiment Control#

提出了一个可扩展的跨体现人形机器人控制框架,通过学习共享的潜在表示来统一人类与多种人形平台的运动。方法分为两阶段:首先使用对比学习构建解耦的潜在空间,然后在该空间中直接训练目标条件控制策略。训练后的策略可以直接部署到新机器人上而无需适配。

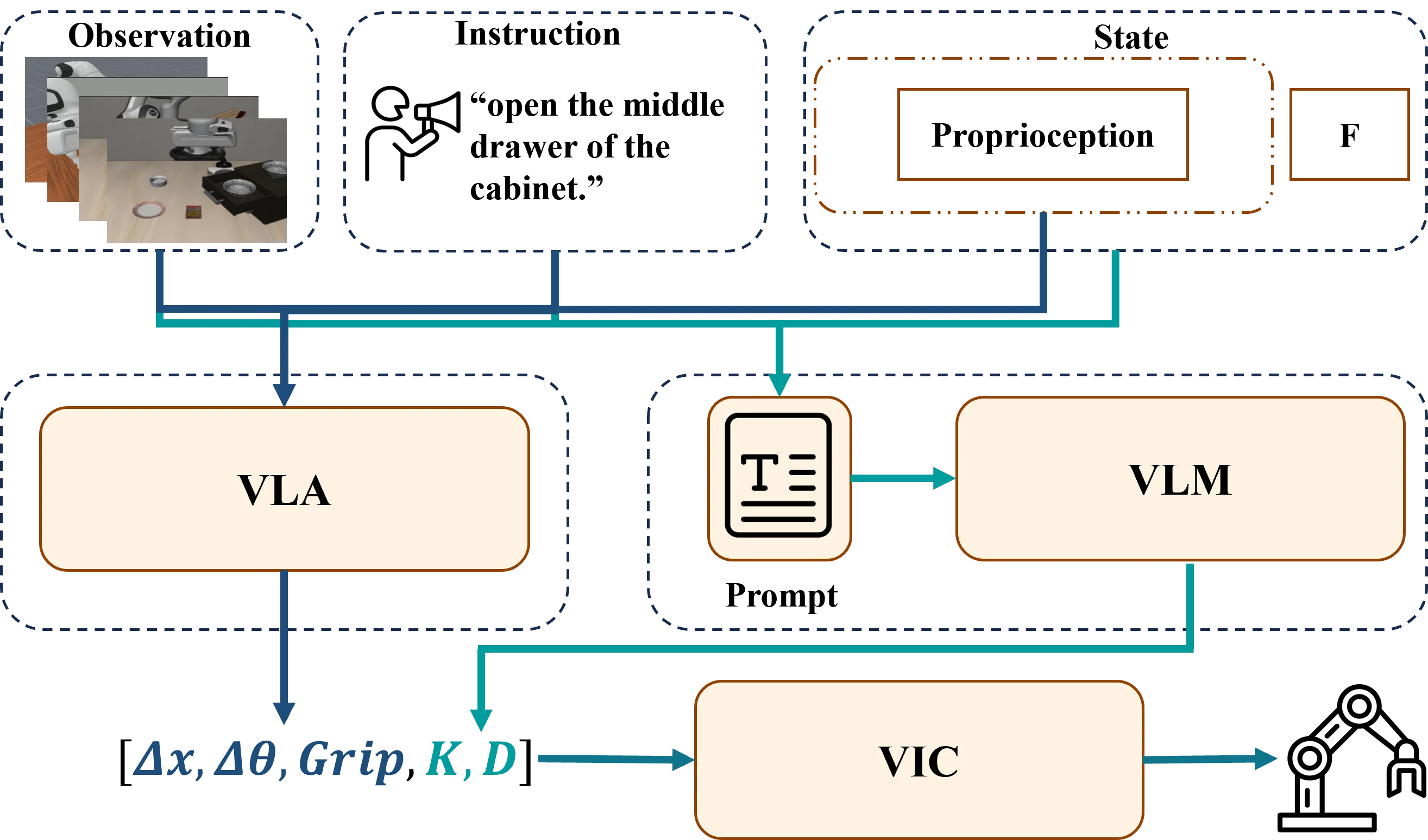

CompliantVLA-adaptor#

提出 CompliantVLA-adaptor,通过结合 VLM 提供的上下文感知可变阻抗控制(VIC)来增强 VLA 模型,实现安全的接触丰富操作。VLM 从图像和自然语言中解释任务上下文,动态调整刚度和阻尼参数,并通过实时力反馈确保交互力在安全阈值内。整体成功率从 9.86% 提升到 17.29%。

TeNet#

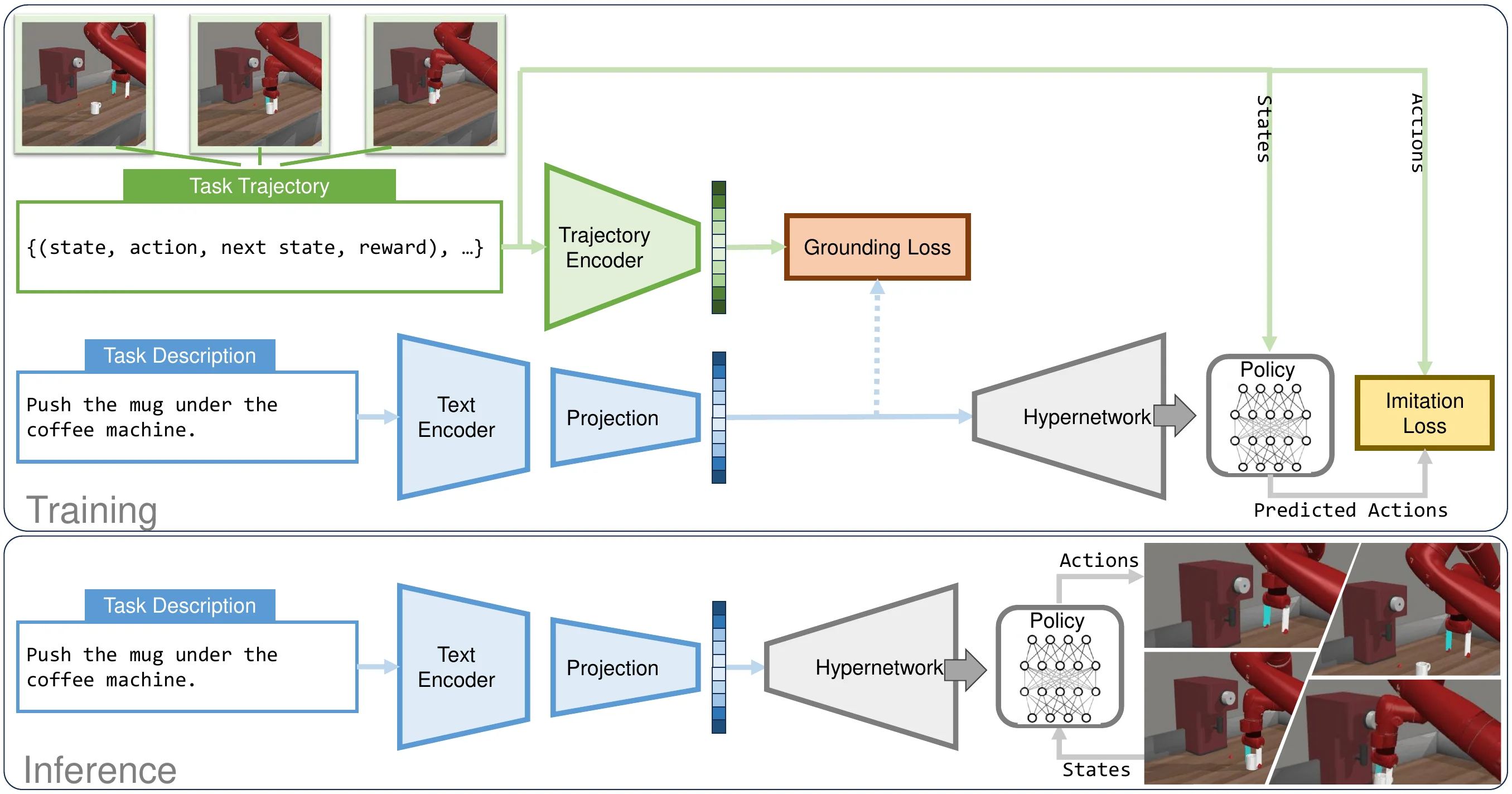

提出 TeNet(Text-to-Network),一个直接从自然语言描述实例化紧凑、任务特定机器人策略的框架。基于 LLM 生成的文本嵌入条件化超网络,生成仅在高控制频率下对低维状态输入操作的策略。策略比基于序列的基线小几个数量级,同时支持高频控制。

DextER#

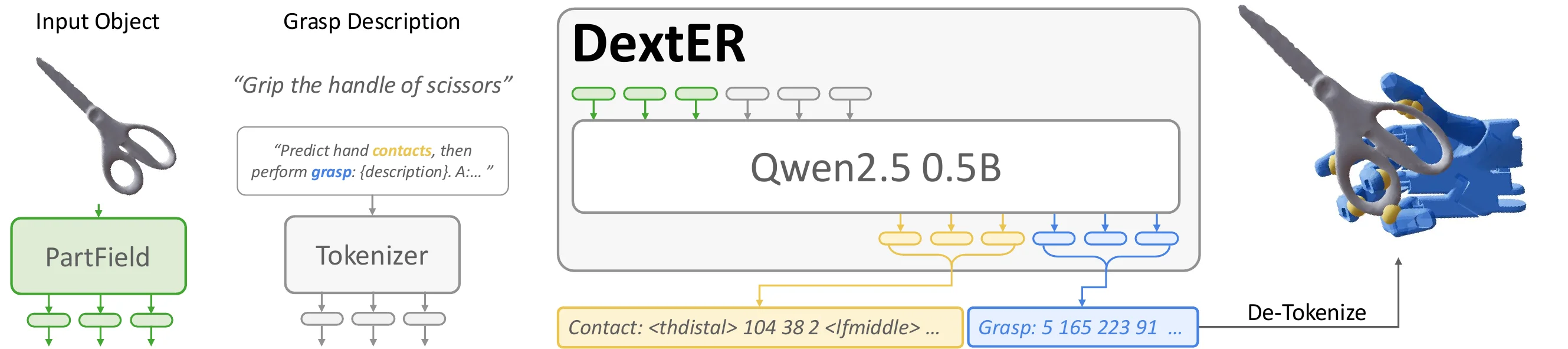

提出 DextER(Dexterous grasp generation under Embodied Reasoning),引入基于接触的具身推理实现多指操控。核心思想是预测哪个手指在物体表面的哪个位置接触,提供连接任务语义与物理约束的中间表示。在 DexGYS 上实现 67.14% 成功率,并支持通过部分接触规范实现可控生成。

IVRA#

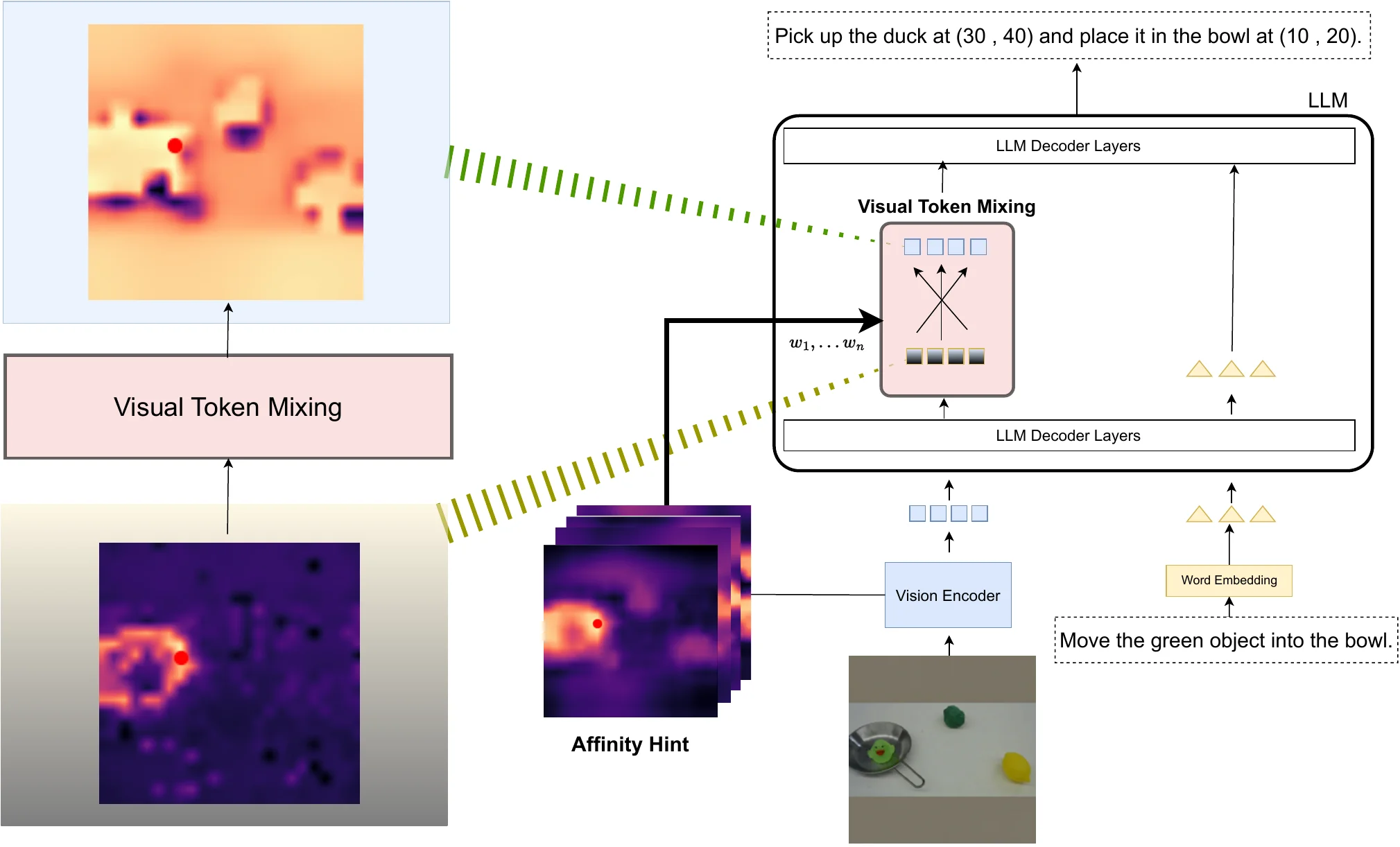

提出 IVRA,一种轻量级无训练方法,通过利用 VLA 模型内置视觉编码器中的亲和性提示来改善空间理解。选择性地将这些信号注入到语言模型层中,重新对齐视觉-标记交互并更好地保留几何结构,无需任何外部编码器或重训练。在 VIMA 和 LIBERO 上均有提升。

Point Bridge#

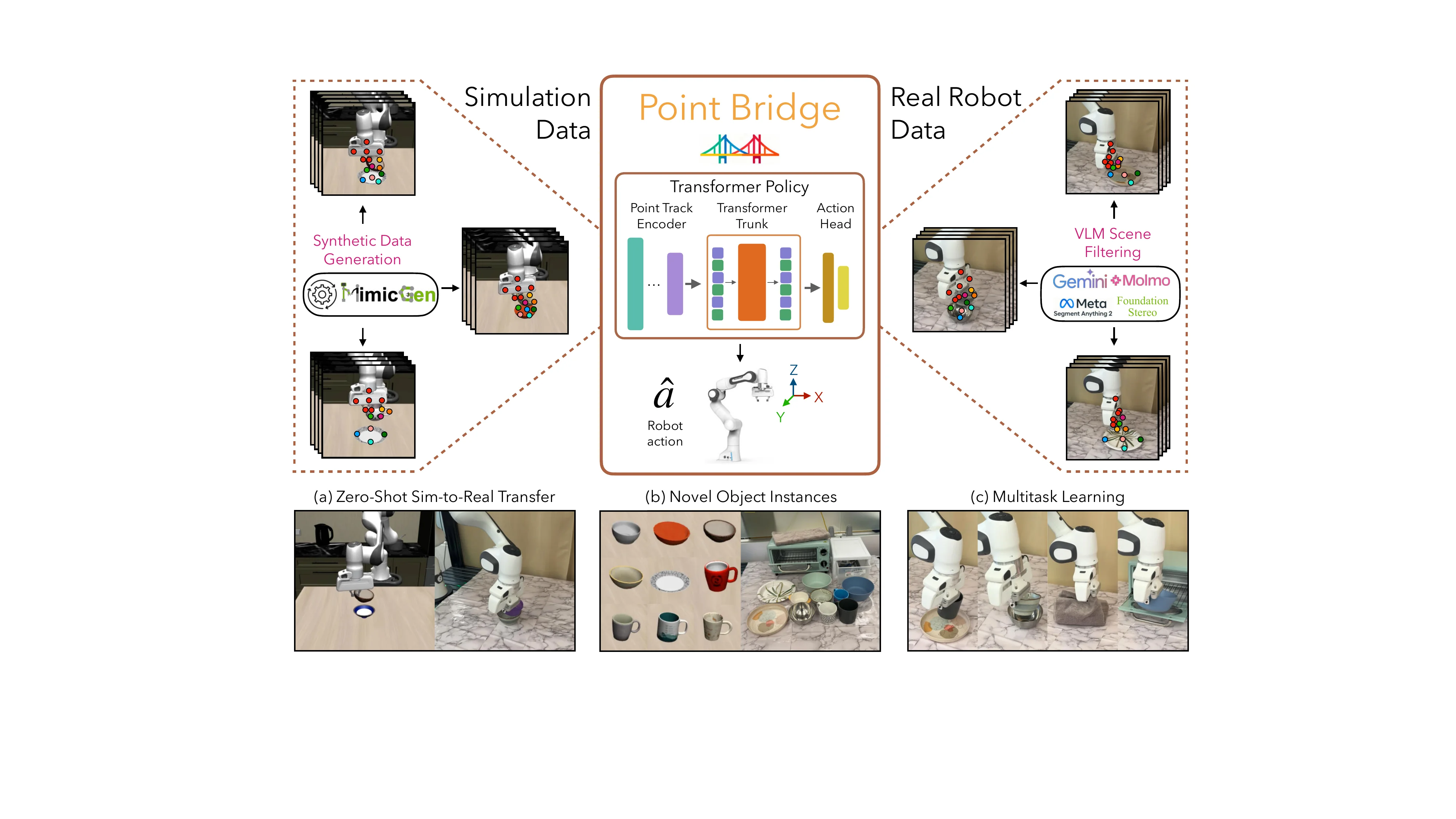

提出 Point Bridge,利用统一的、领域无关的基于点的表示来实现零-shot 仿真到现实策略转移,无需显式的视觉或对象级对齐。结合 VLM 自动提取的基于点的表示、Transformer 策略学习和高效推理管道。在零-shot sim-to-real 转移中实现高达 44% 的提升。

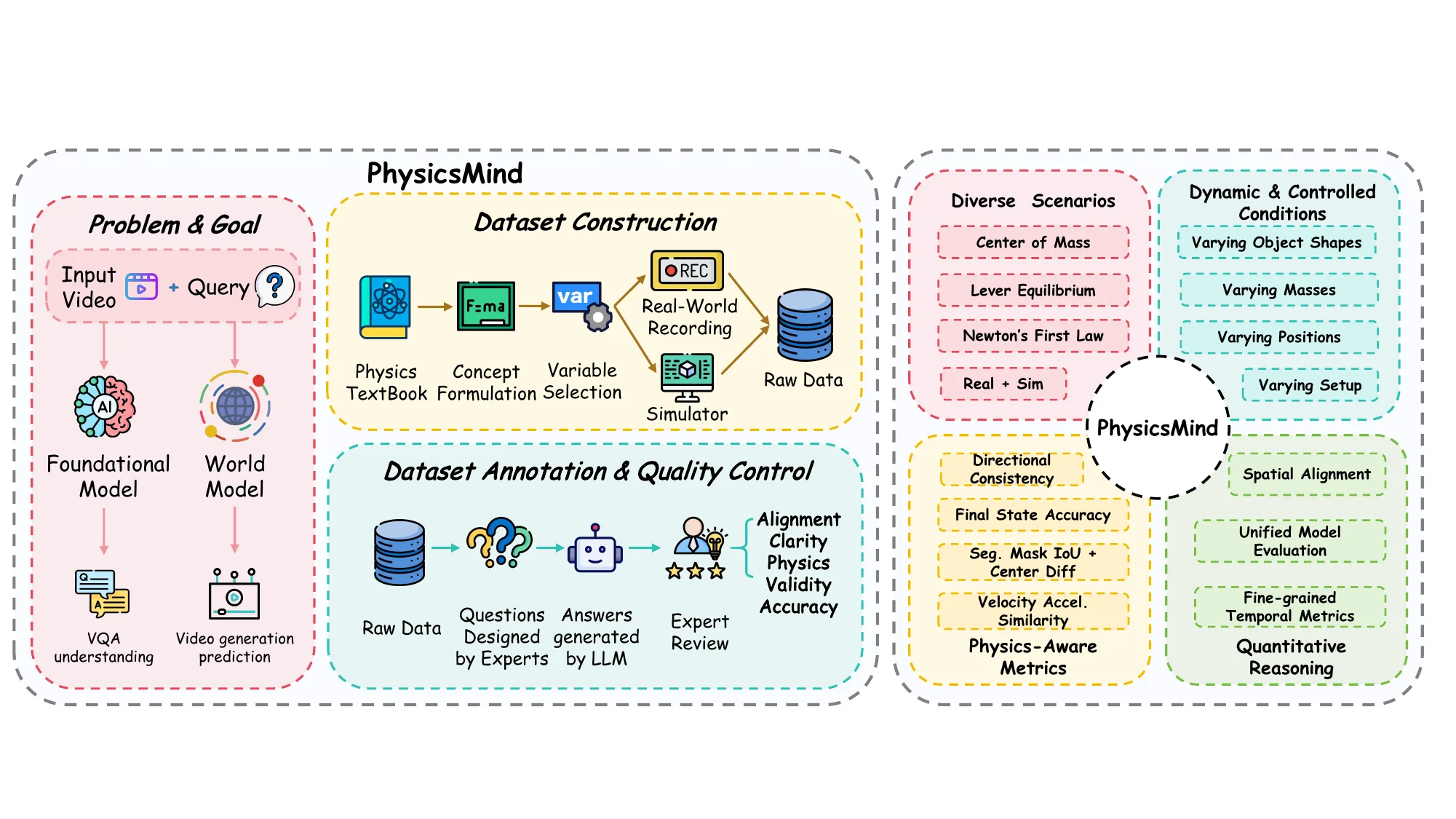

PhysicsMind#

引入 PhysicsMind,一个统一的基准评估 VLM 和世界模型的物理推理能力,包含真实和模拟环境,基于质心、杠杆平衡和牛顿第一定律三个经典原则。包含 VQA 任务和视频生成任务。结果表明当前模型依赖外观启发式,常常违反基本力学。

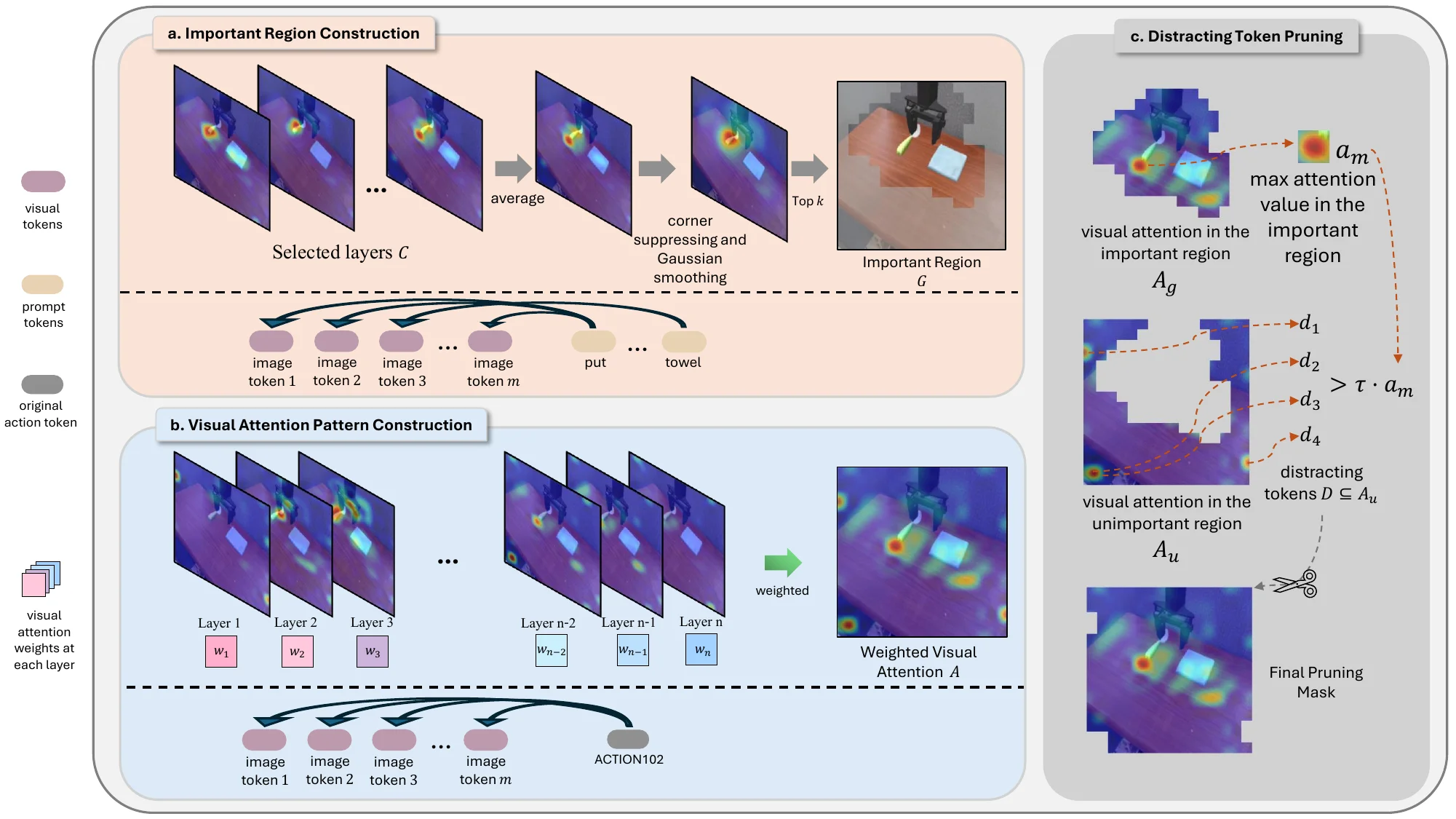

DTP#

提出 DTP(Distracting Token Pruning),一个简单即插即用的框架,动态检测并修剪 VLA 模型中的”干扰标记”——模型过度关注的任务无关区域的图像标记。通过纠正模型的视觉注意模式来提高任务成功率,无需改变原始架构。在 SIMPLER 基准上展示了普适性。

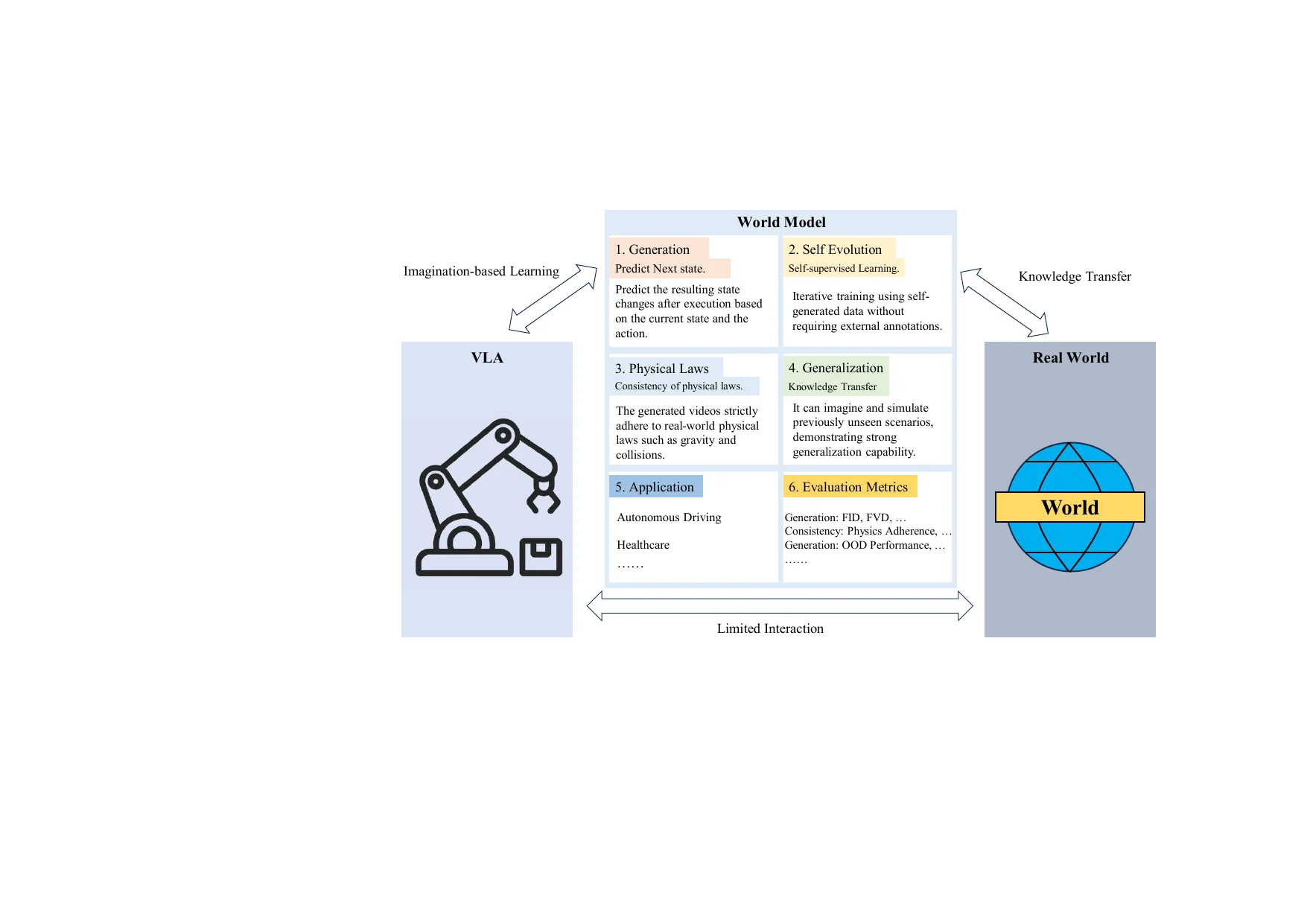

World Model Physics#

综述性工作,指出当前世界模型存在”视觉混淆”问题:高保真视频生成并不意味着对物理和因果动态的理解。建议将世界模型重新定义为可操作的模拟器而非视觉引擎,强调结构化的四维接口、约束感知的动态以及闭环评估。

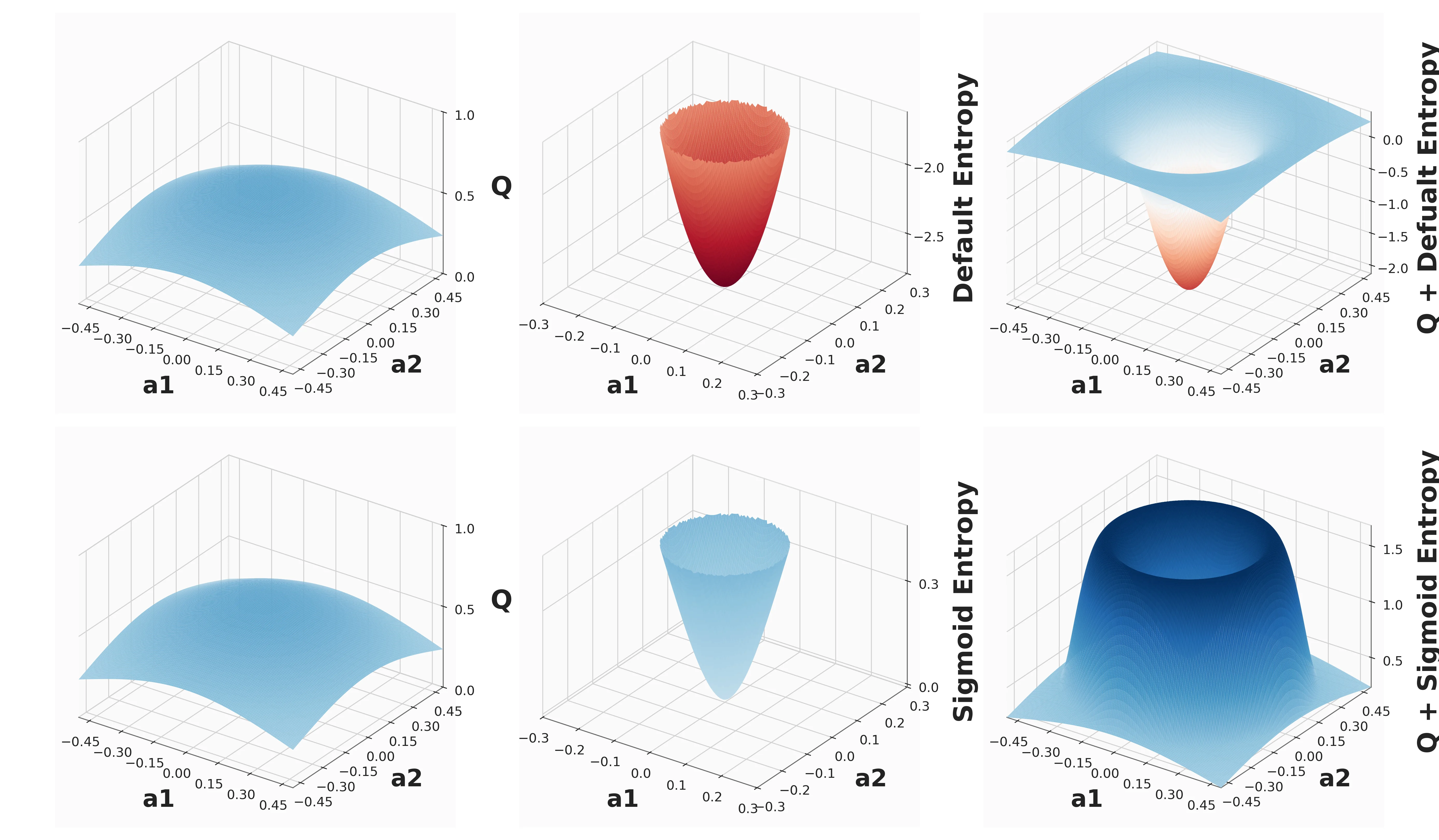

SigEnt-SAC#

提出 SigEnt-SAC,一种离策略演员-评论家方法,能够从头开始学习,仅使用单条专家轨迹。关键设计是 sigmoid 界限熵项,防止负熵驱动的优化朝向分布外动作,减少 Q 函数振荡。在多个现实世界机器人任务上验证,代理从原始图像和稀疏奖励中学习。

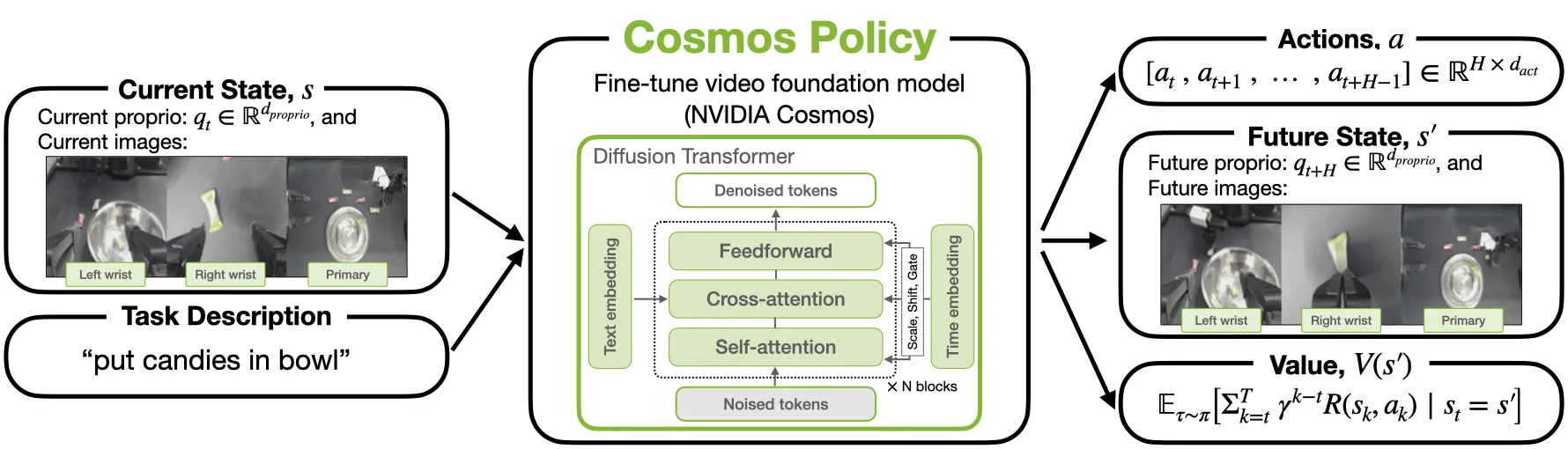

Cosmos Policy#

提出 Cosmos Policy,通过单阶段后训练将大型预训练视频模型(Cosmos-Predict2)转化为有效机器人策略,无需架构修改。学习直接生成作为潜在帧编码的机器人动作,利用模型的预训练先验。在 LIBERO 和 RoboCasa 上实现 SOTA(分别 98.5% 和 67.1%)。

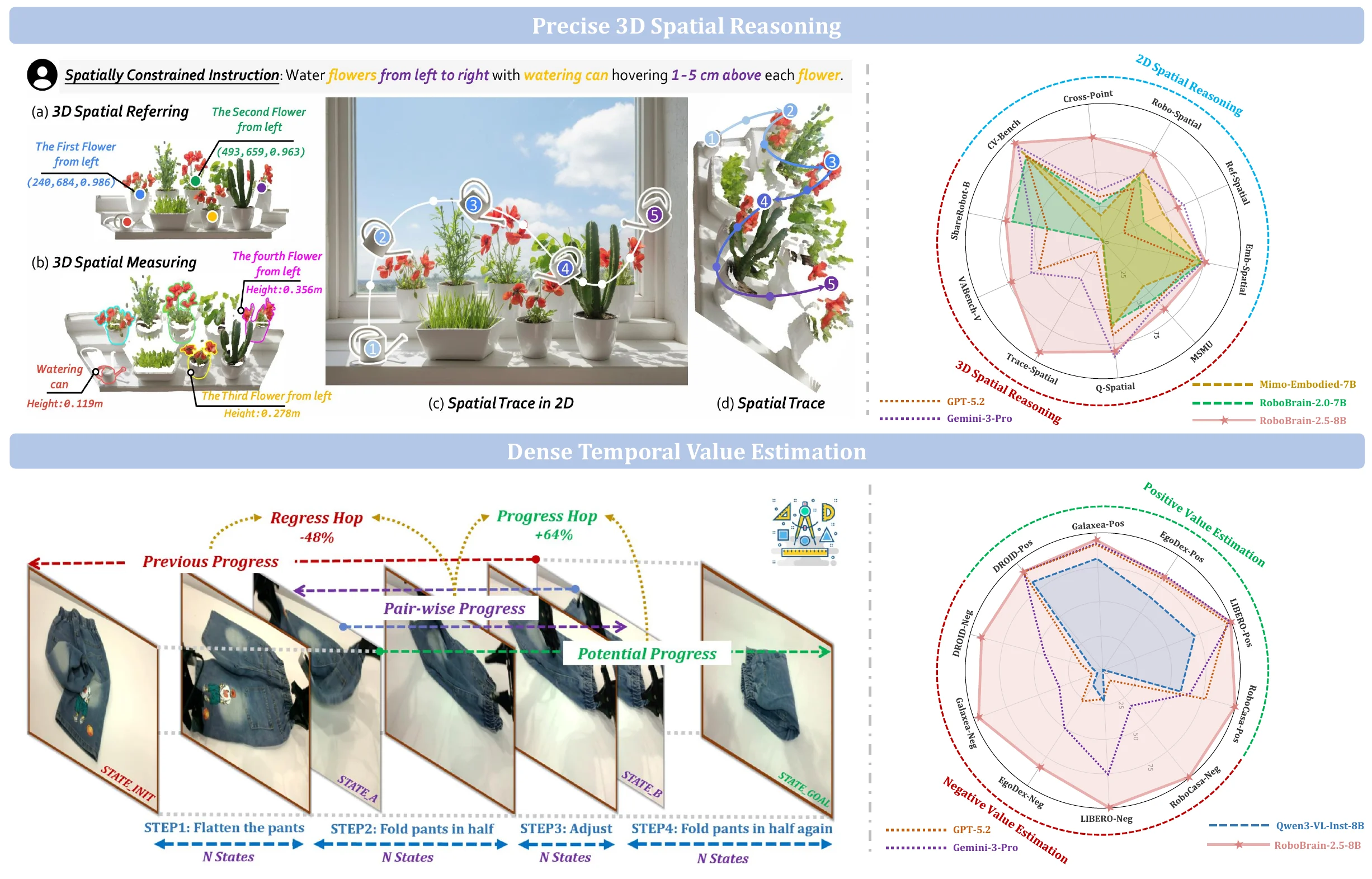

RoboBrain 2.5#

RoboBrain 2.5 是下一代具身人工智能基础模型,通过高质量时空监督推动通用感知、空间推理和时间建模的发展。该模型引入两项核心升级:精确的三维空间推理(从二维像素相对定位转向深度感知坐标预测和绝对度量约束理解,生成物理约束下的完整三维操作轨迹)和密集时间值估计(提供跨视角的逐步进展预测和执行状态理解)。这些升级共同将框架扩展到更具物理基础和执行意识的具身智能。

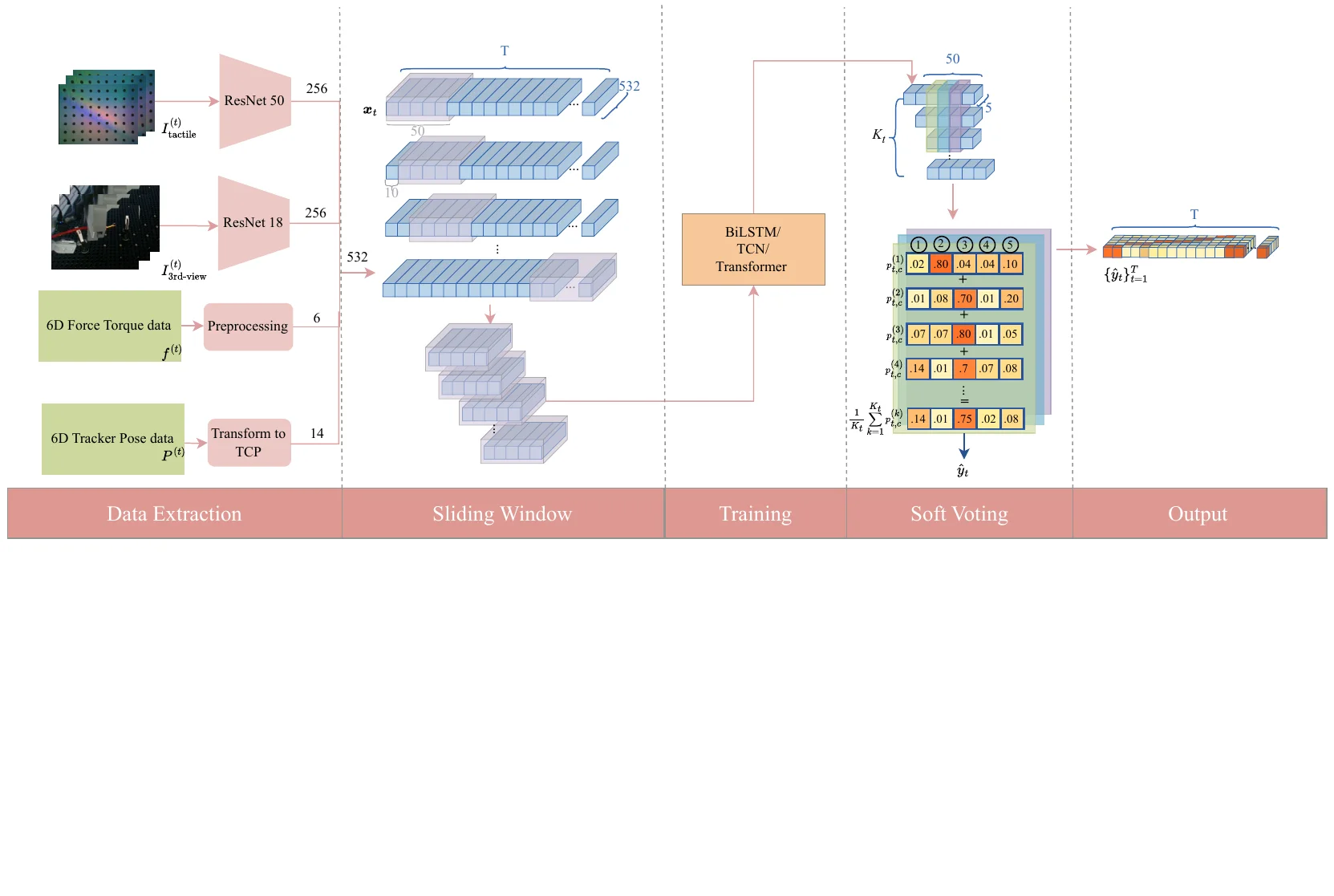

TacUMI#

TacUMI 是一种用于接触丰富任务的多模态通用操作接口,在 UMI 的基础上额外集成了 ViTac 传感器、力-扭矩传感器和姿态追踪器,设计为紧凑的机器人兼容夹持器,实现人工演示过程中多模态数据的同步采集。该系统还提出了一种多模态分割框架,利用时间模型检测顺序操作中的语义事件边界,在电缆安装任务上实现超过 90% 的分割准确率,验证了多模态数据在接触丰富任务中的显著改善。

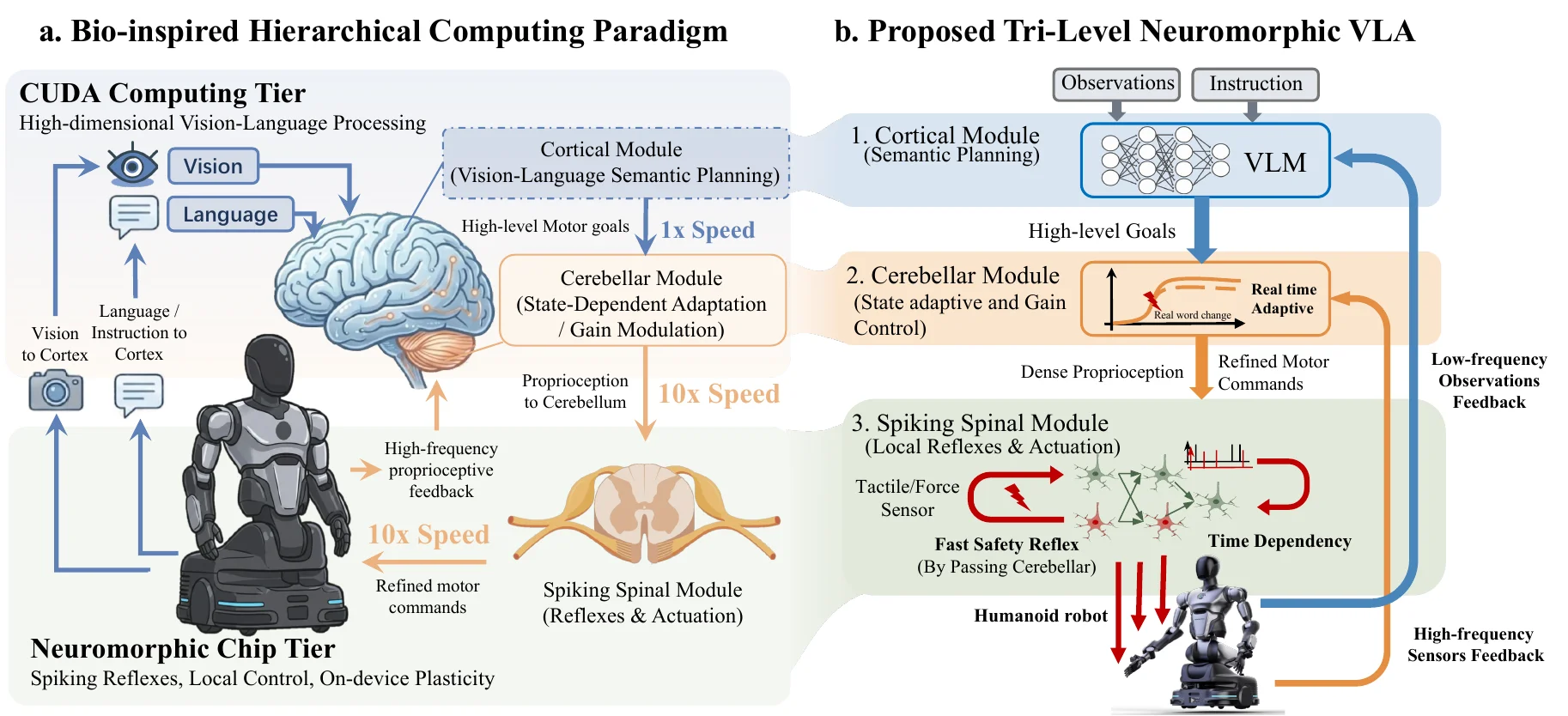

NeuroVLA#

NeuroVLA 是一种脑启发的具身智能框架,模仿生物神经系统在皮层、小脑和脊髓之间的结构组织,实现流畅快速的反射性机器人控制。该系统采用三层生物启发设计:高层模型规划目标,自适应小脑模块利用高频传感器反馈稳定运动,脊髓层执行快速动作生成。NeuroVLA 是神经形态 VLA 在物理机器人上的首次应用,消除了机器人手臂抖动,在神经形态处理器上仅消耗 0.4 瓦,并能在 20 毫秒内触发安全反射。

Spatially Generalizable Mobile Manipulation#

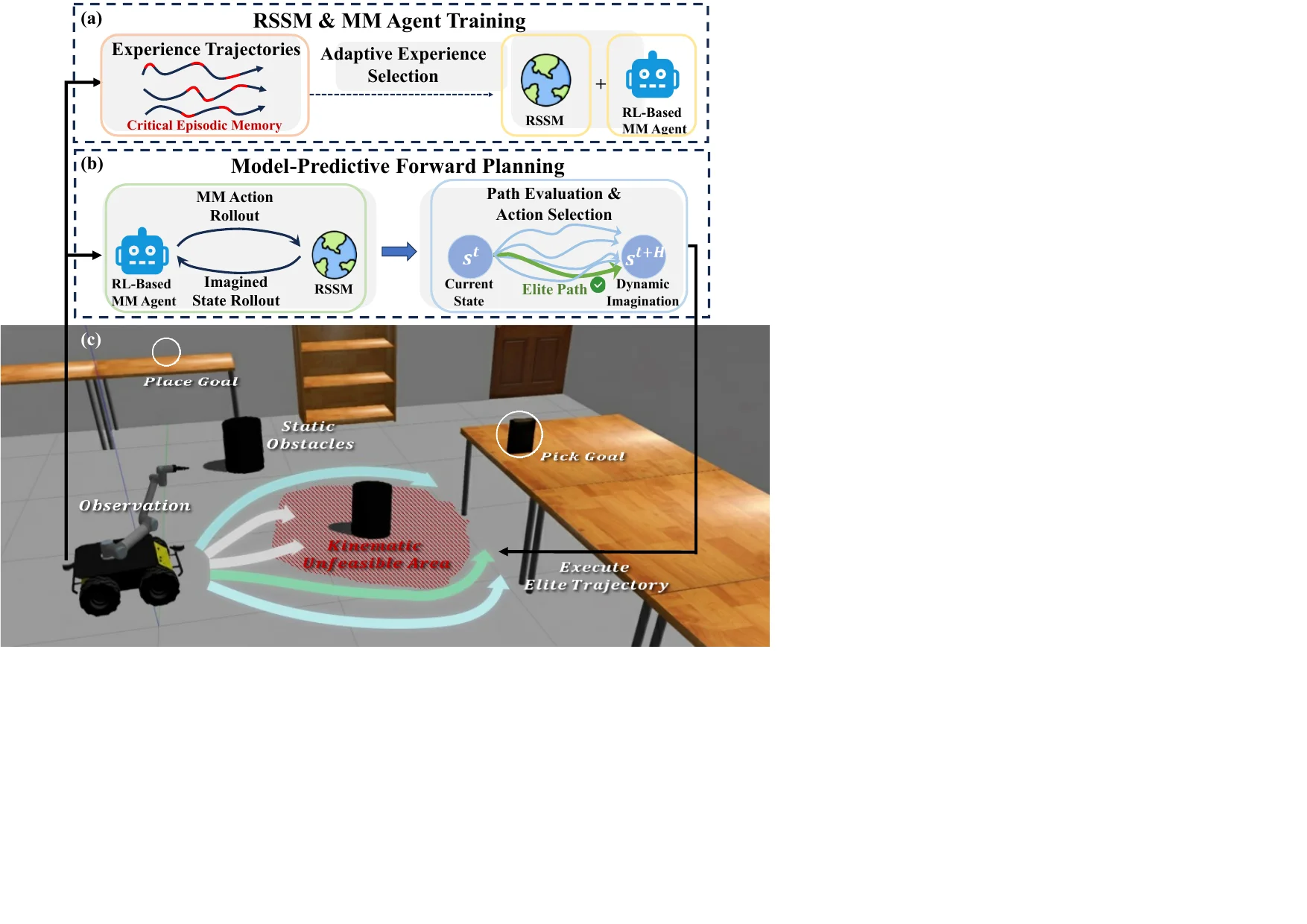

本文通过自适应经验选择(AES)和基于模型的动态想象解决移动操控中的样本效率和空间泛化问题。AES 使代理更加关注长轨迹中影响任务成功的关键经验片段,改善技能链学习并减轻技能遗忘。在此基础上,引入递归状态空间模型(RSSM)用于模型预测前向规划,通过捕捉移动底座与操控器之间的耦合动态实现向新空间布局的有效推广。

BayesianVLA#

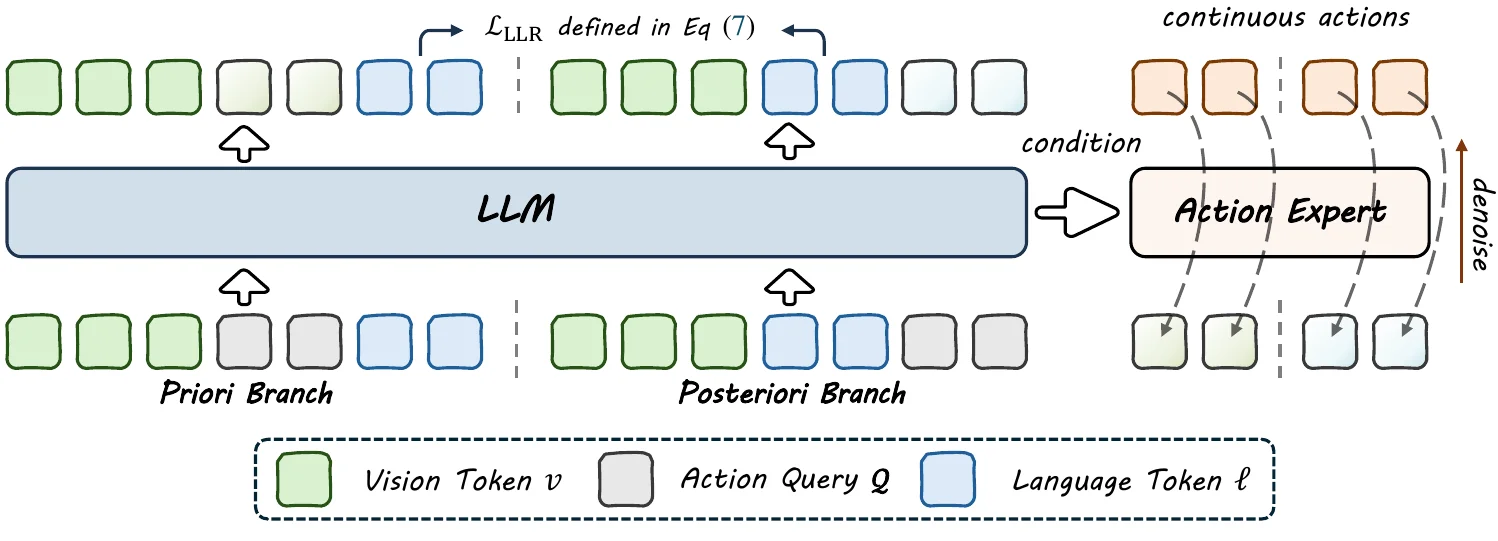

BayesianVLA 通过贝叶斯分解解决 VLA 模型中的”信息崩溃”问题——目标驱动数据收集导致语言指令可仅通过视觉观察预测,使模型退化为视觉策略而忽视语言约束。该框架引入可学习的潜在动作查询构建双分支架构,分别估计视觉优先分布和语言条件后验分布,通过最大化动作与指令之间的条件点互信息来惩罚视觉捷径并奖励明确解释语言命令的动作。

CADGrasp#

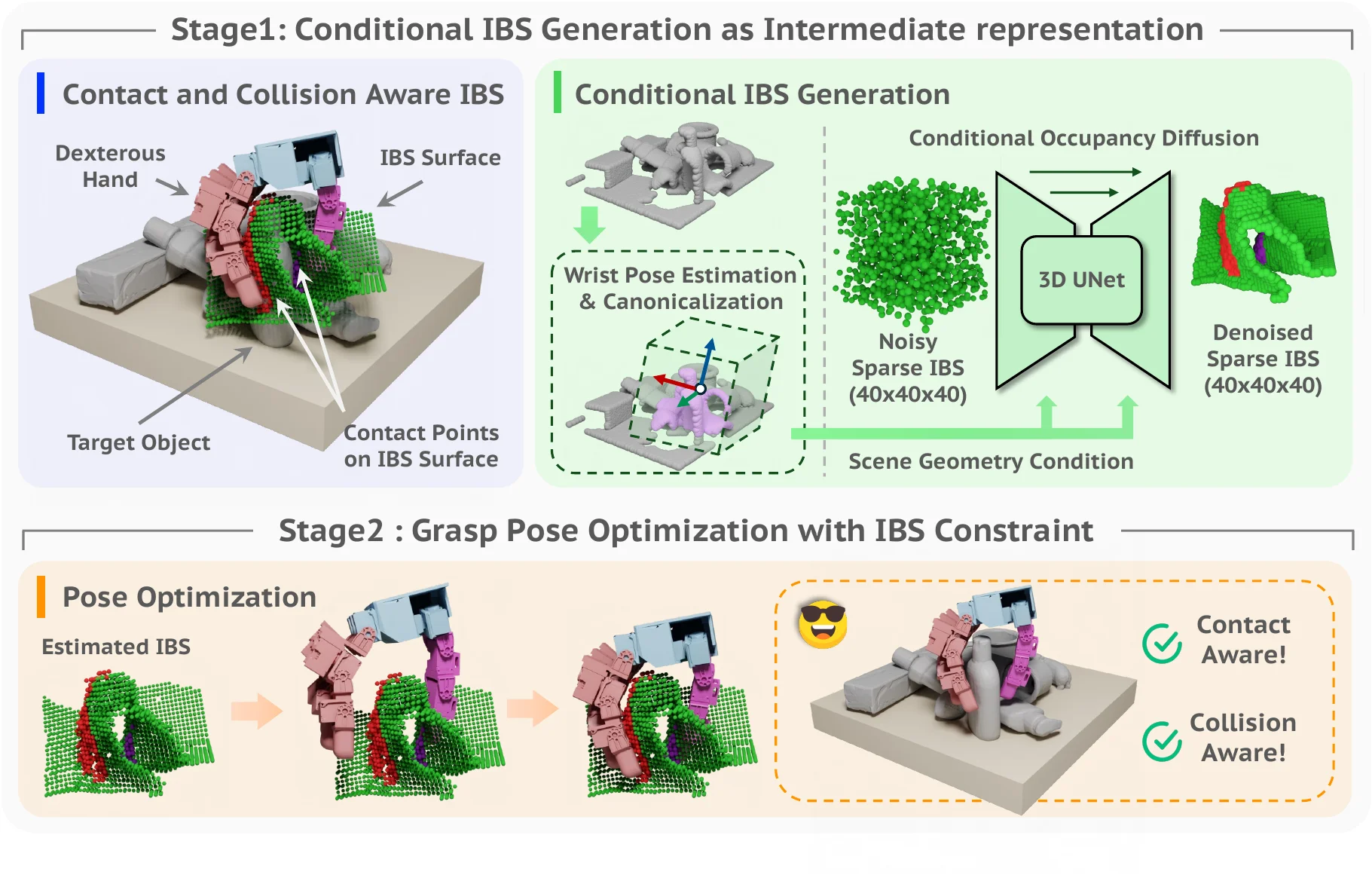

CADGrasp 是一种基于单视角点云的通用灵巧抓取两阶段算法,解决杂乱环境中灵巧手高自由度、遮挡和潜在碰撞带来的挑战。第一阶段预测稀疏 IBS(场景解耦的、考虑接触和碰撞的表示)作为优化目标,通过占用扩散模型增强预测能力;第二阶段基于稀疏 IBS 开发能量函数和排序策略进行优化,生成高质量灵巧抓取姿态。实验验证了该方法在多样化物体和复杂场景中减轻碰撞的能力,同时保持高抓取成功率。

ReViP#

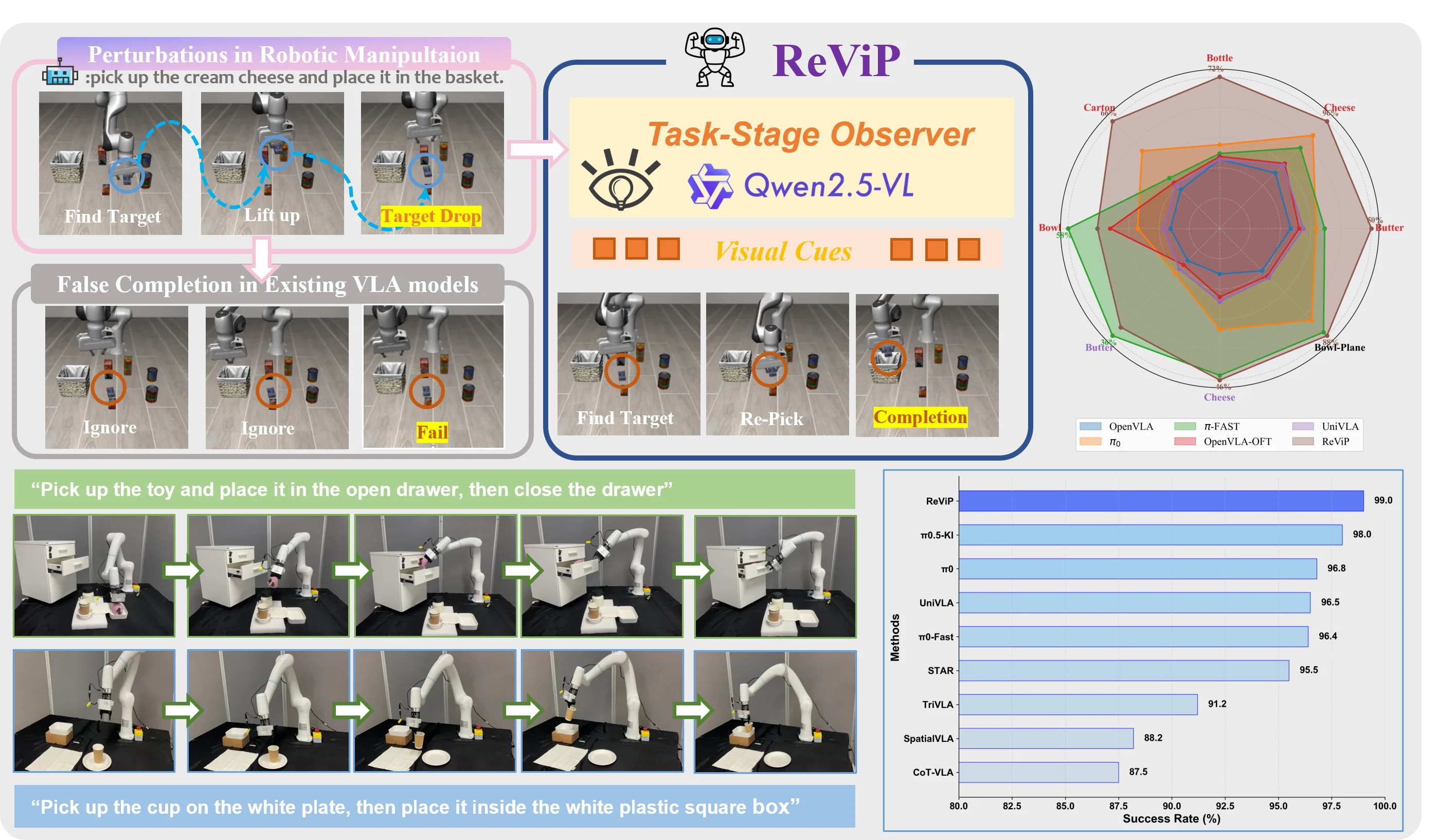

ReViP 提出了一种新颖的 VLA 框架,通过视觉-本体感知重平衡解决现有方法中的”错误完成”问题——即模型过度依赖内部状态而忽视视觉证据,导致在执行明显失败时仍报告任务完成。该方法引入外部 VLM 作为任务阶段观察者,提取实时任务中心视觉线索,通过视觉-本体感知特征线性调制增强环境意识。论文还提出了首个基于 LIBERO 的错误完成基准套件(包含物体掉落等受控设置)。实验表明 ReViP 有效降低了错误完成率,在 LIBERO、RoboTwin 2.0 和真实世界评估中均优于强 VLA 基线。

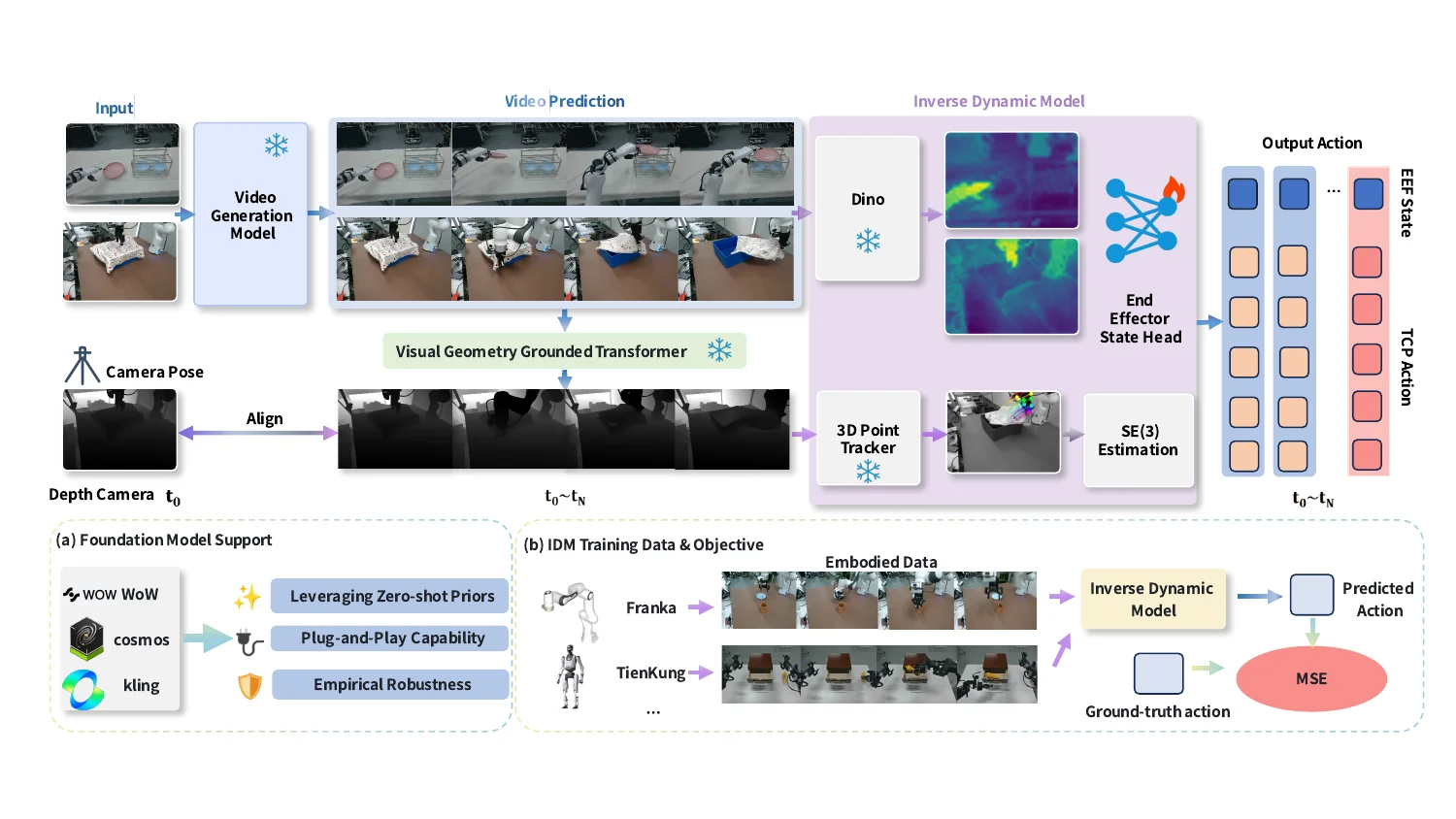

TC-IDM#

TC-IDM(Tool-Centric Inverse Dynamics Model)提出了一种工具中心逆动力学模型,通过关注工具在世界模型中想象的轨迹,弥合视觉规划与物理控制之间的差距。该方法从生成的视频中通过分割和三维运动估计提取工具的点云轨迹,采用解耦的动作头将计划轨迹投影到 6 自由度末端执行器运动。这种计划与转换范式支持广泛的末端执行器,显著提高视角不变性,并在长时域和超出分布的任务中表现出强大泛化能力。在现实世界评估中,结合 TC-IDM 的世界模型实现了 61.11% 的平均成功率,在简单任务中达到 77.7%,在零-shot 可变形物体任务中达到 38.46%。

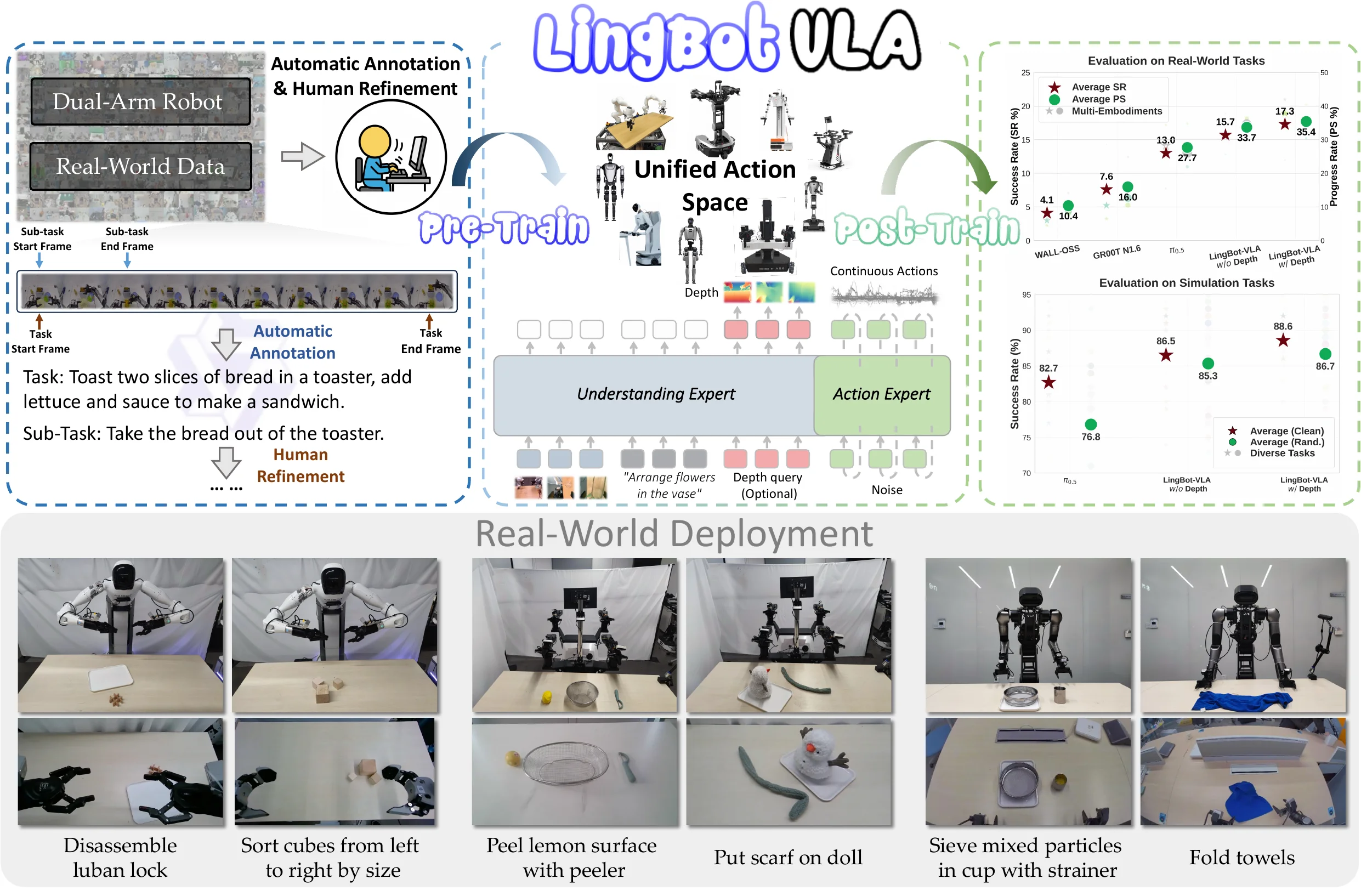

LingBot-VLA#

LingBot-VLA 是一个实用的视觉-语言-动作基础模型,使用来自 9 种流行双臂机器人配置的约 20,000 小时真实世界数据训练。通过对 3 个机器人平台进行系统评估(每个平台 100 个任务、130 个训练后实验),该模型展示了强大的性能和广泛的泛化能力。研究团队建立了高效代码库,在 8-GPU 训练设置下提供每秒 261 个样本的吞吐量,相较于现有 VLA 代码库速度提升了 1.5~2.8 倍。该模型提供代码、基础模型和基准数据的开放访问,重点在于实现更具挑战性的任务并促进健全的评估标准。

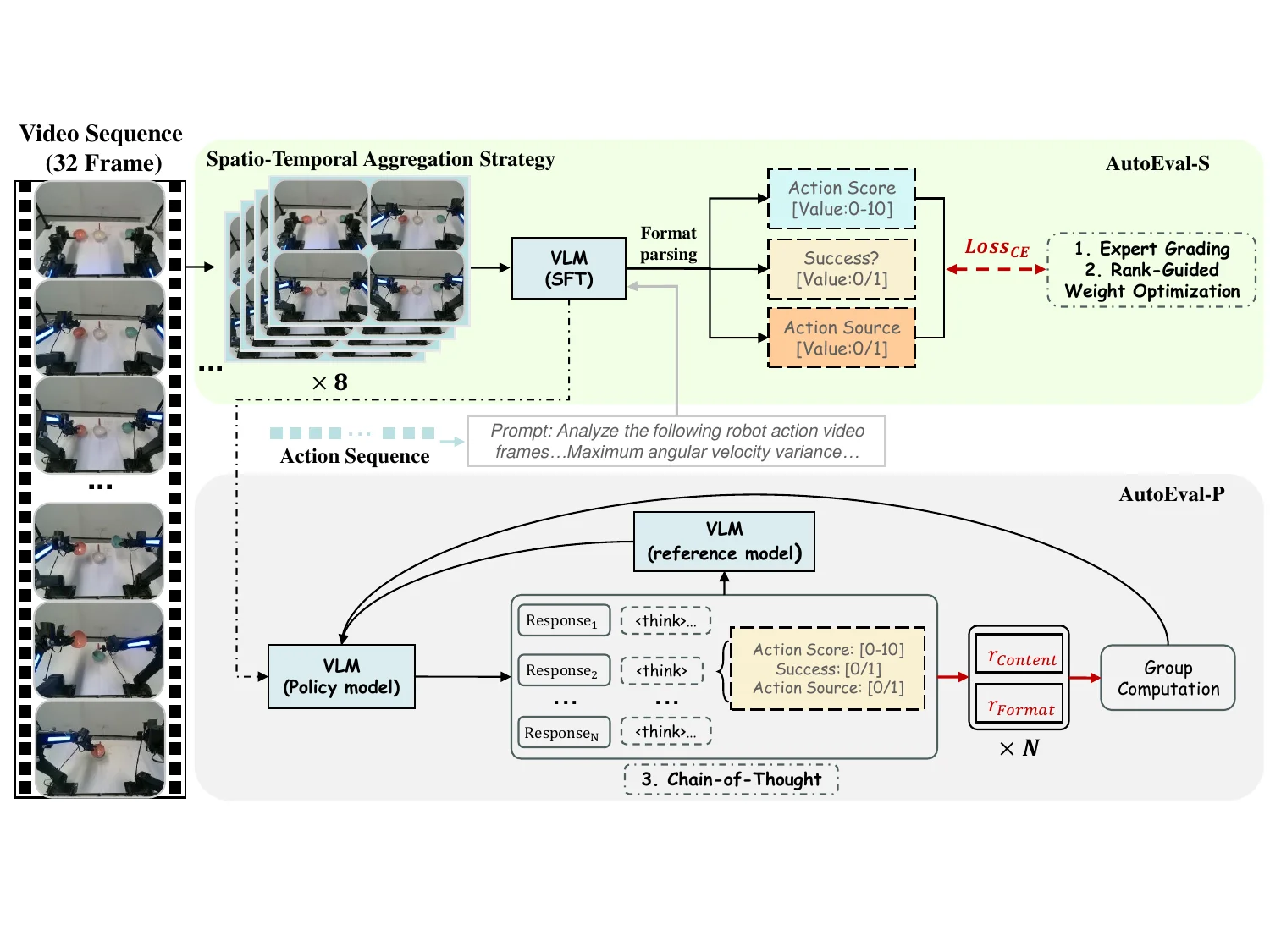

Eval-Actions#

Eval-Actions 针对 VLA 模型评估方法滞后的问题,提出了结合 Eval-Actions 基准和 AutoEval 架构的解决方案。该基准整合了 VA 和 VLA 策略执行轨迹以及人类遥控操作数据,明确包含失败场景,围绕专家评分(EG)、排名引导偏好(RG)和思维链(CoT)三个核心监督信号构建。该工作解决了评估信任的关键维度:源真实性(区分真实策略行为与人类遥控操作)和执行质量(平滑性和安全性),为建立可信的机器人操作评估提供了新方向。

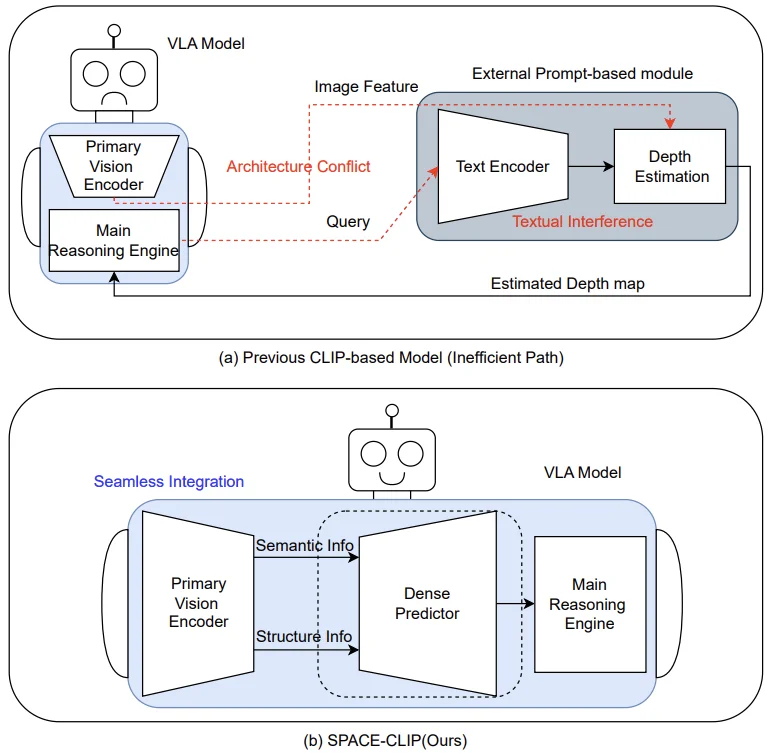

SPACE-CLIP#

SPACE-CLIP 提出了一种从冻结的 CLIP 视觉编码器直接解锁和解释潜在几何知识的架构,完全绕过文本编码器。该方法采用双通道解码器:语义通道解释高层特征并通过 FiLM 进行动态条件处理,结构通道从早期层提取细粒度空间细节,两条路径在每个上采样阶段进行分层融合。在 KITTI 基准上的实验表明 SPACE-CLIP 显著优于之前基于 CLIP 的方法。该方法不仅是独立的深度估计器,更是一个可轻松集成到下一代具身 AI 系统(如 VLA 模型)的空间感知模块。

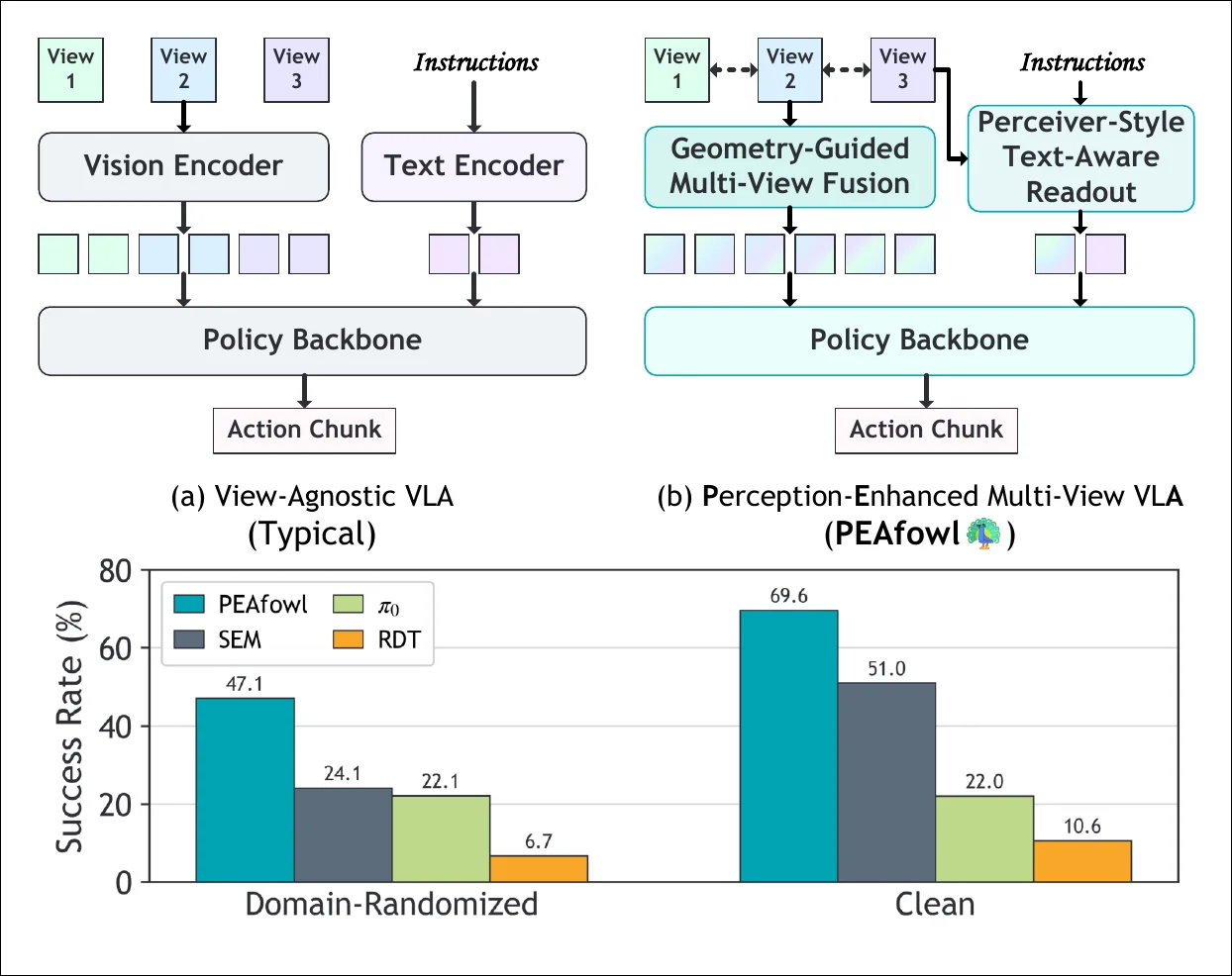

PEAfowl#

PEAfowl(Perception-Enhanced Multi-View VLA)是一种用于双手操作的感知增强多视角视觉-语言-动作策略。针对多视角特征融合和语言条件注入的问题,PEAfowl 预测每个标记的深度分布,执行可微分的 3D 提升,聚合局部跨视角邻居形成几何基础的、跨视角一致的表示;同时用 Perceiver 风格的文本感知读取替代全局条件,实现迭代的证据积累。该方法还应用仅训练时的深度蒸馏克服噪声和不完整的商品深度问题。在 RoboTwin 2.0 上,PEAfowl 成功率比最强基线提高 23.0 个百分点,真实机器人实验证明了可靠的 sim-to-real 迁移。